Paper Review. BERT_Pretraining of Deep Bidirectional Transformers for Language Understanding@NAACL' 2019

Abstract

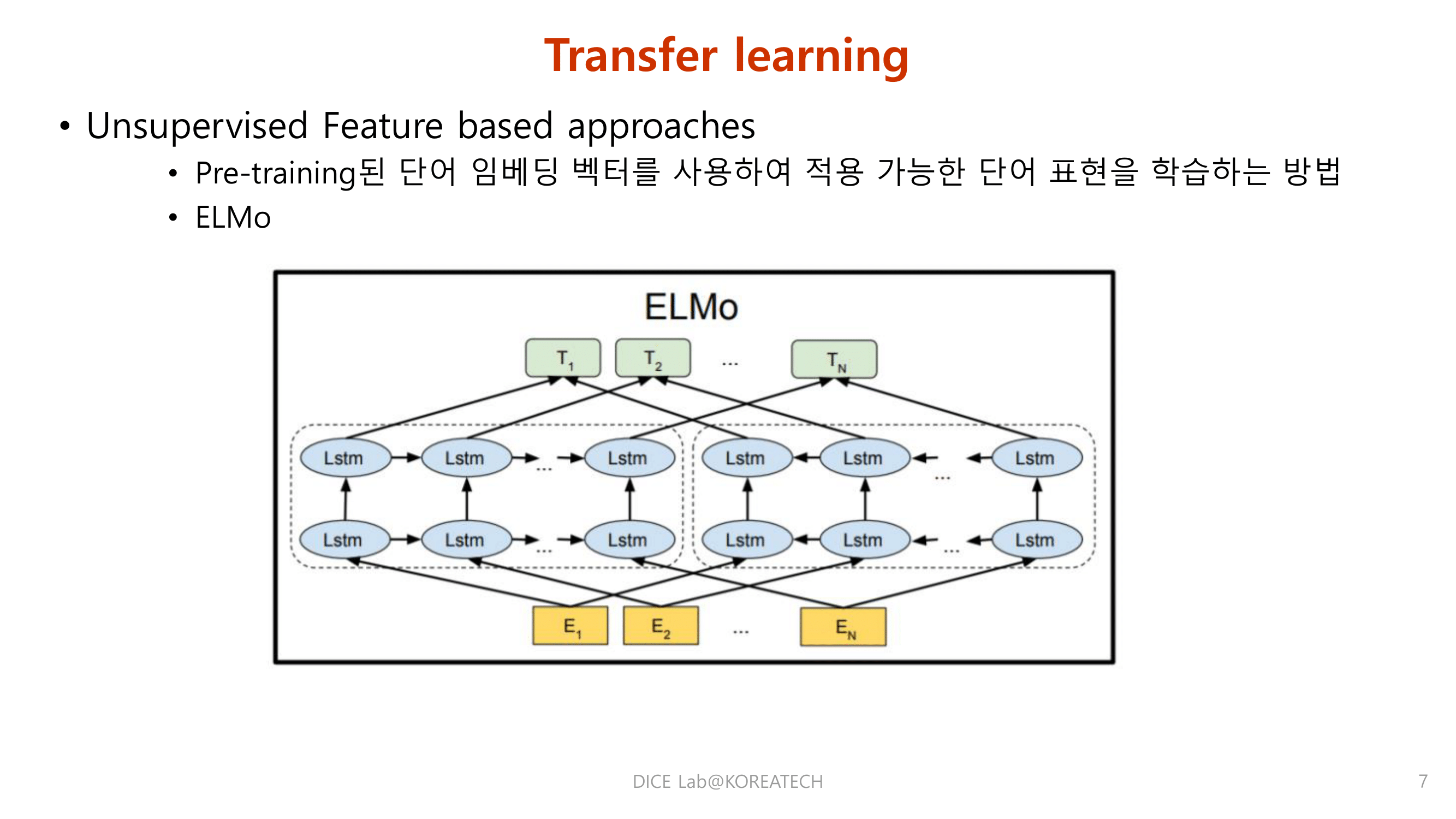

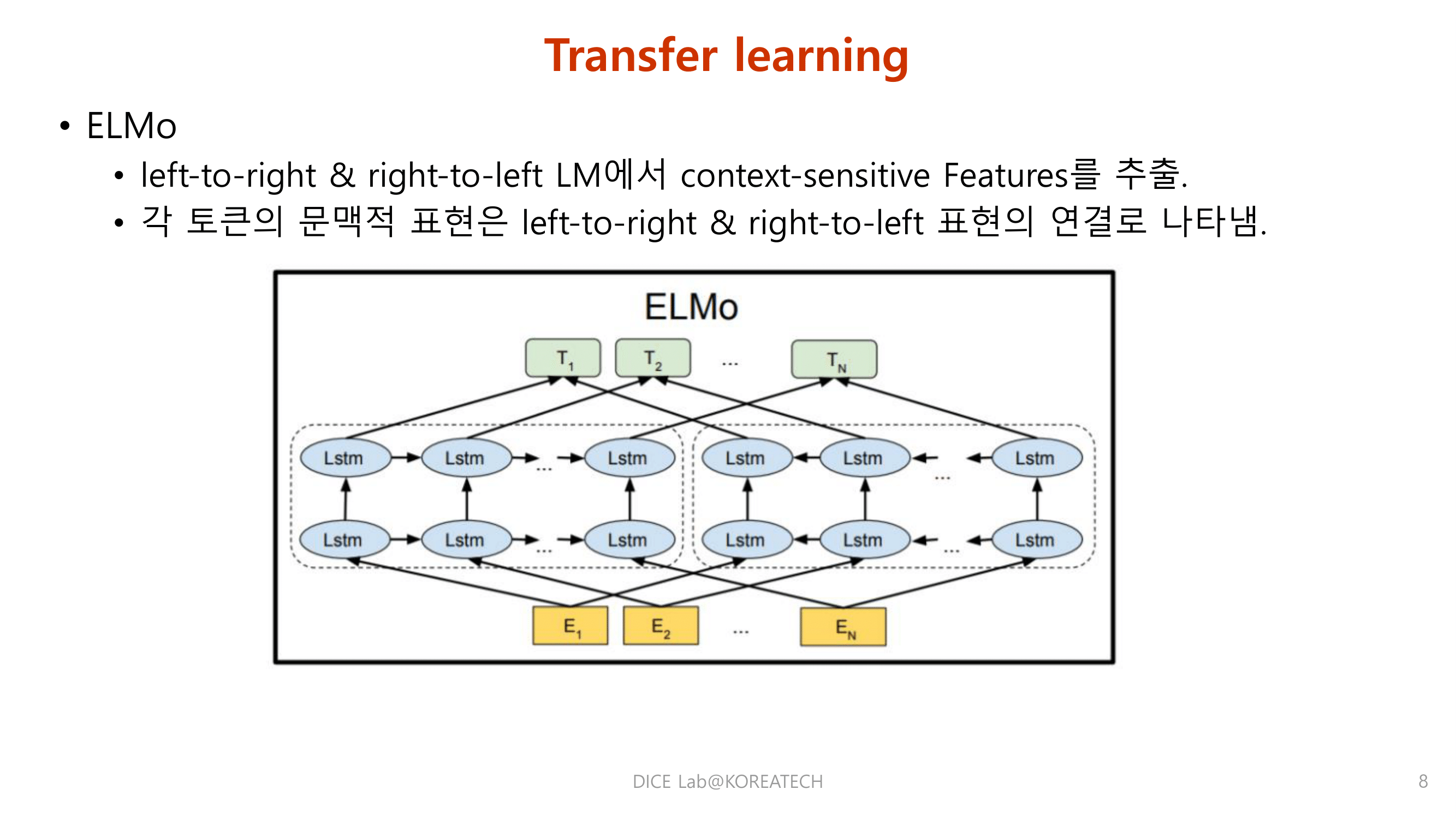

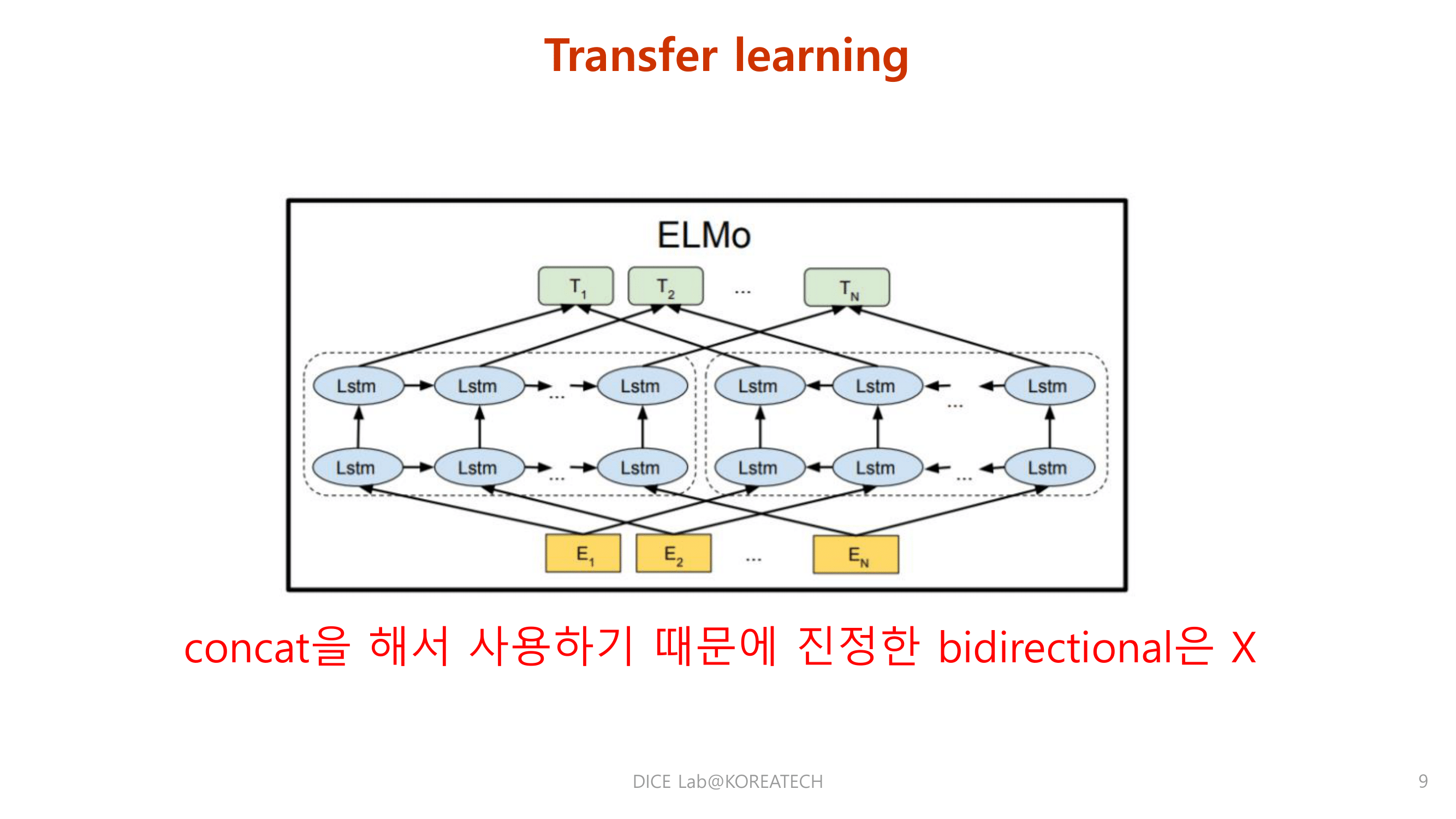

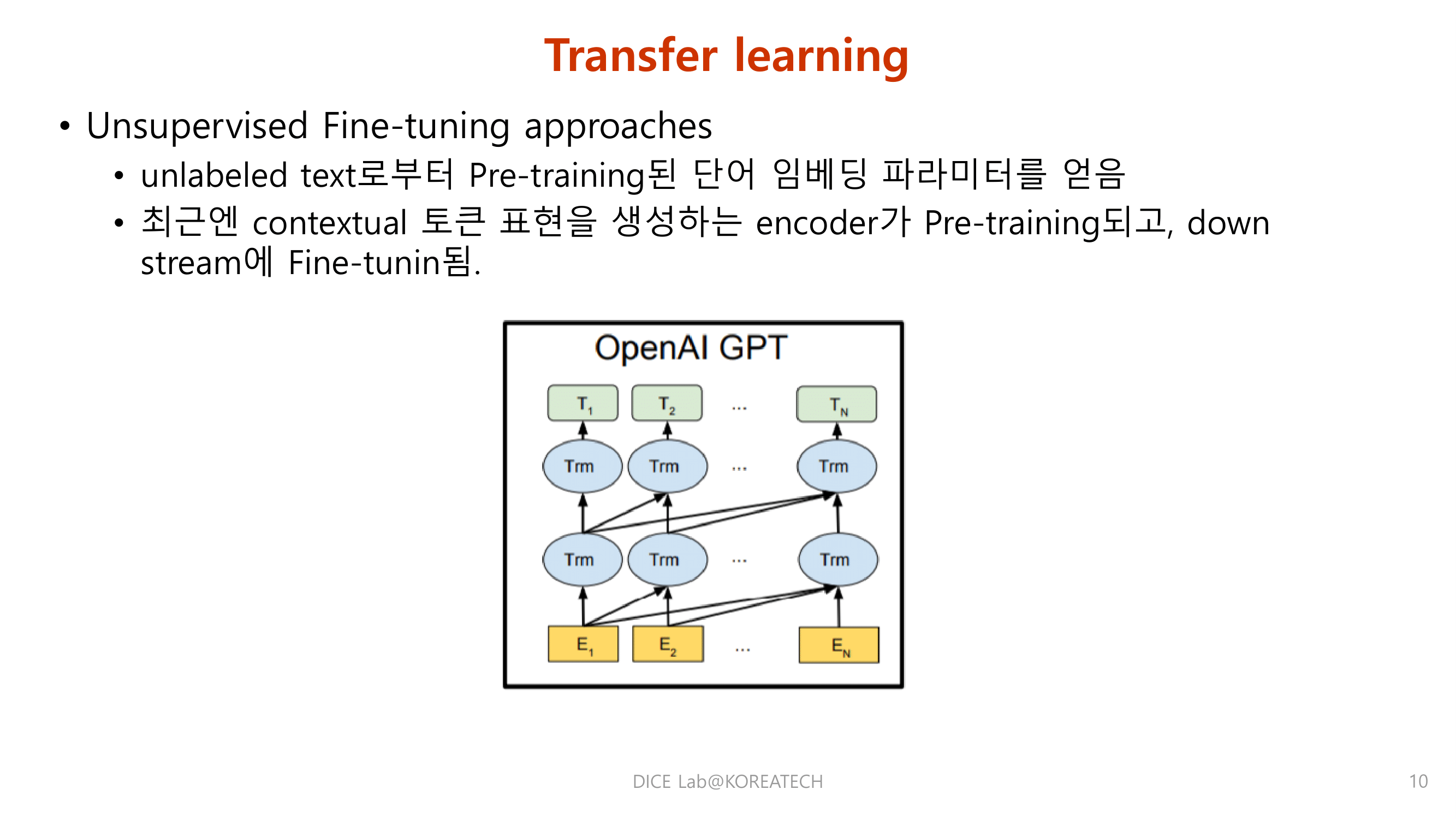

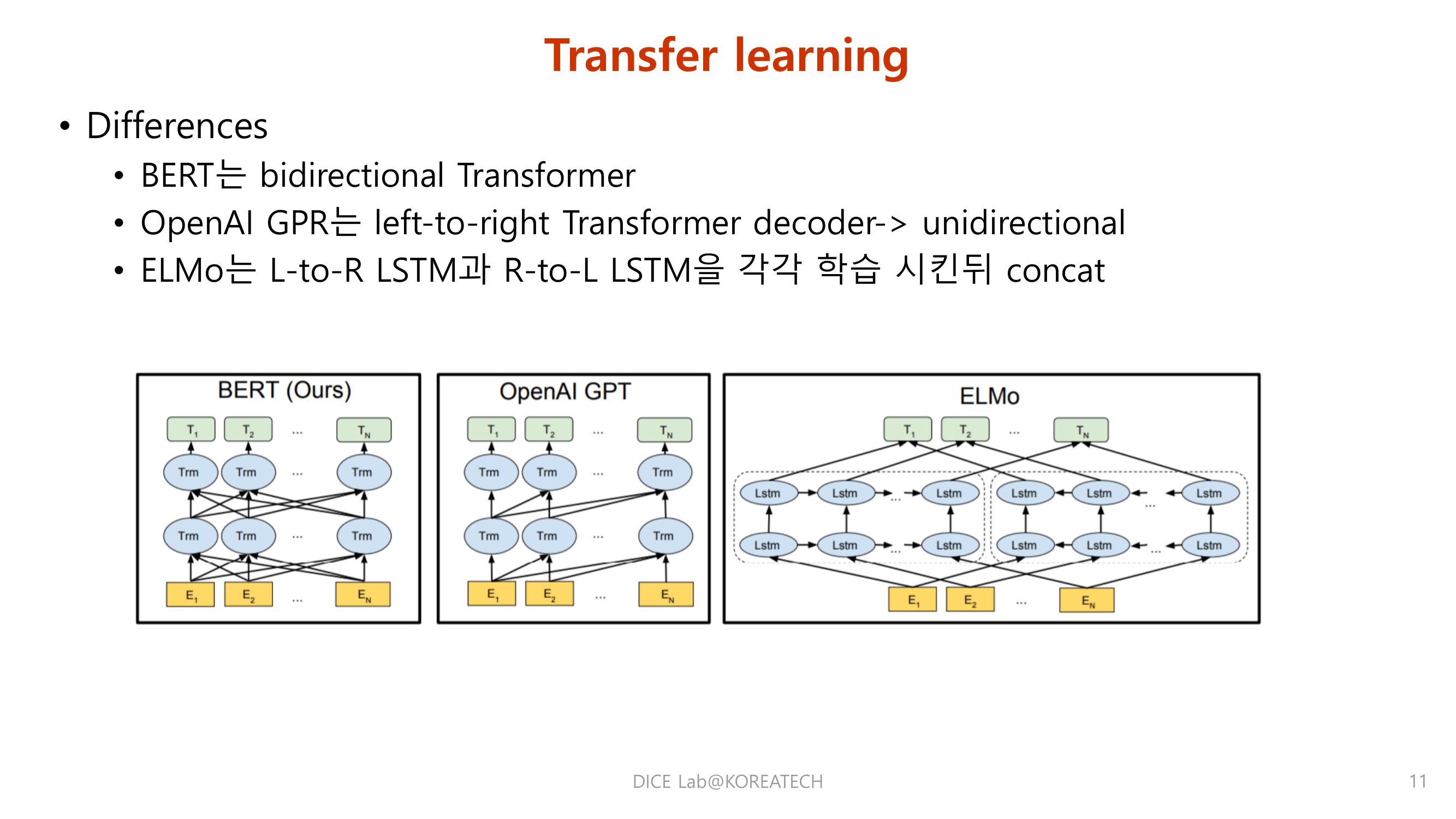

Background

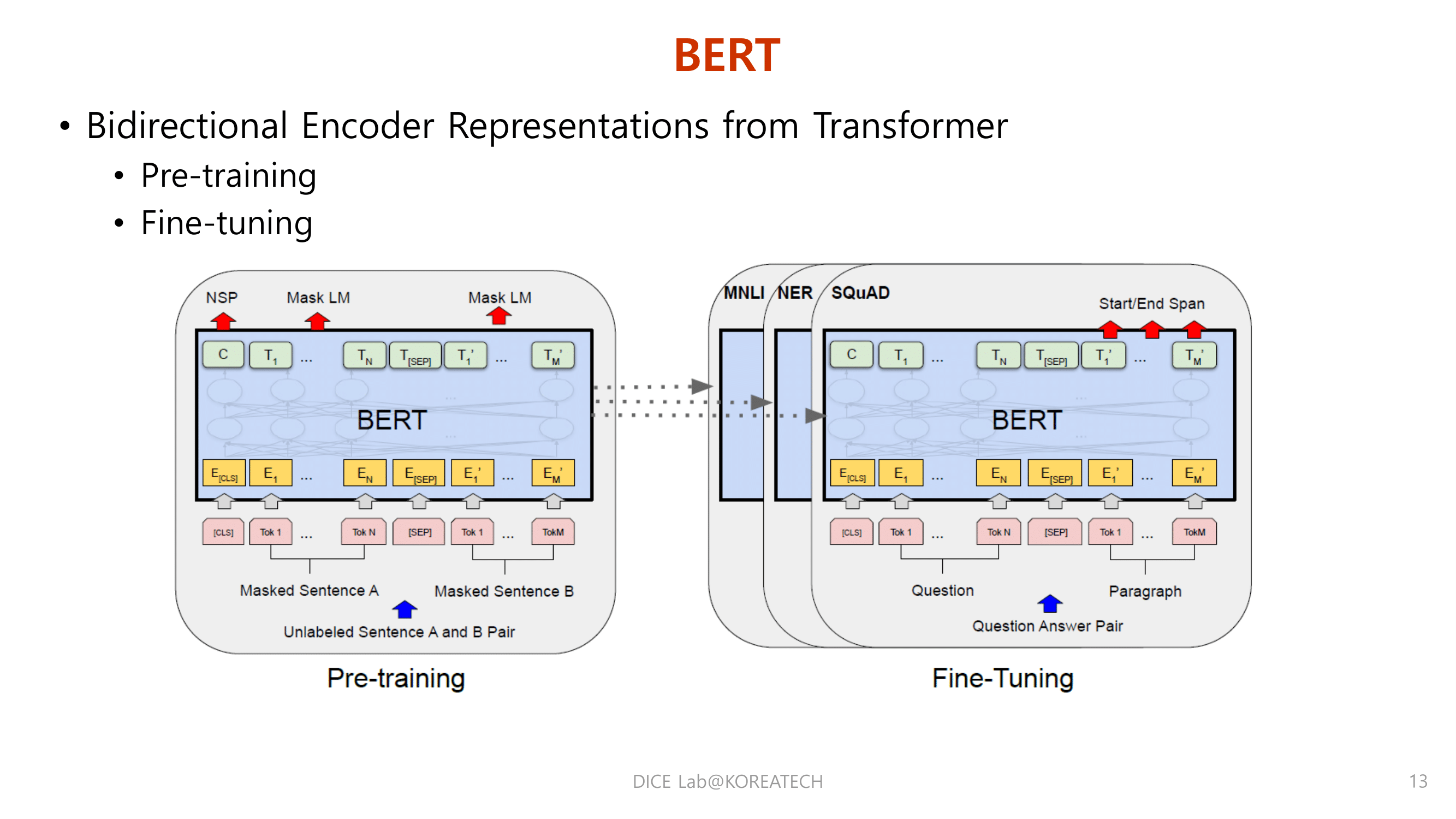

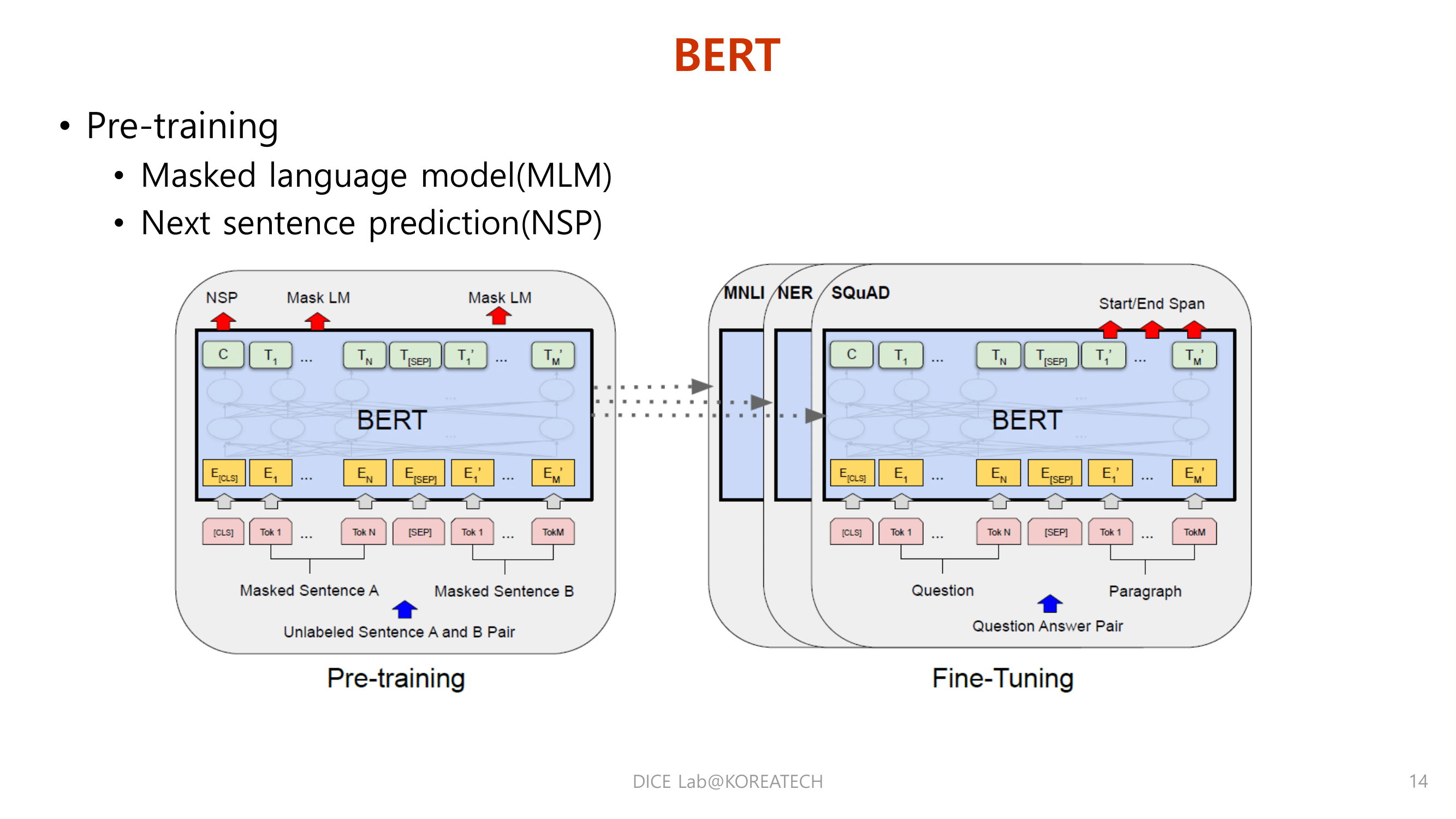

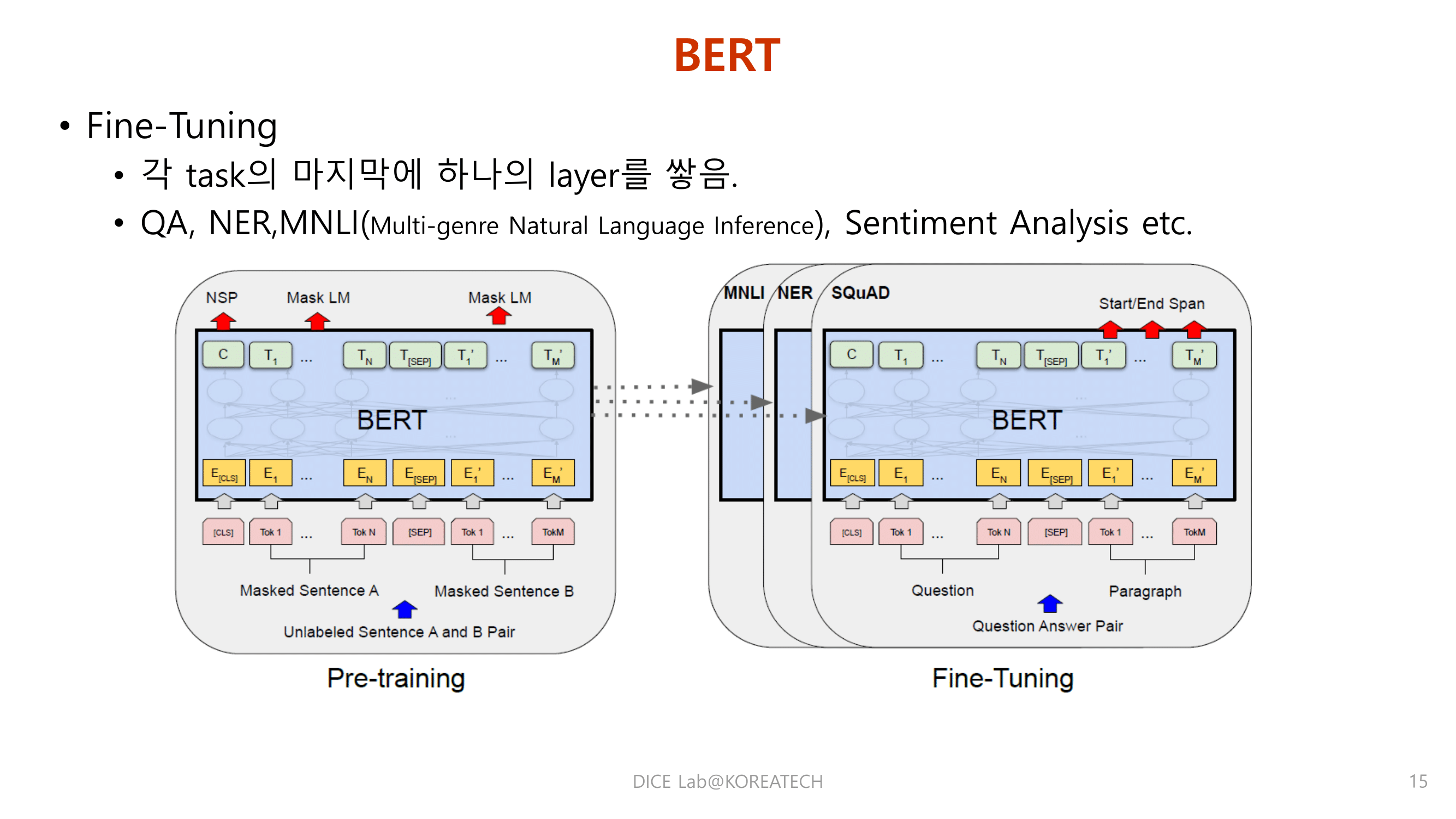

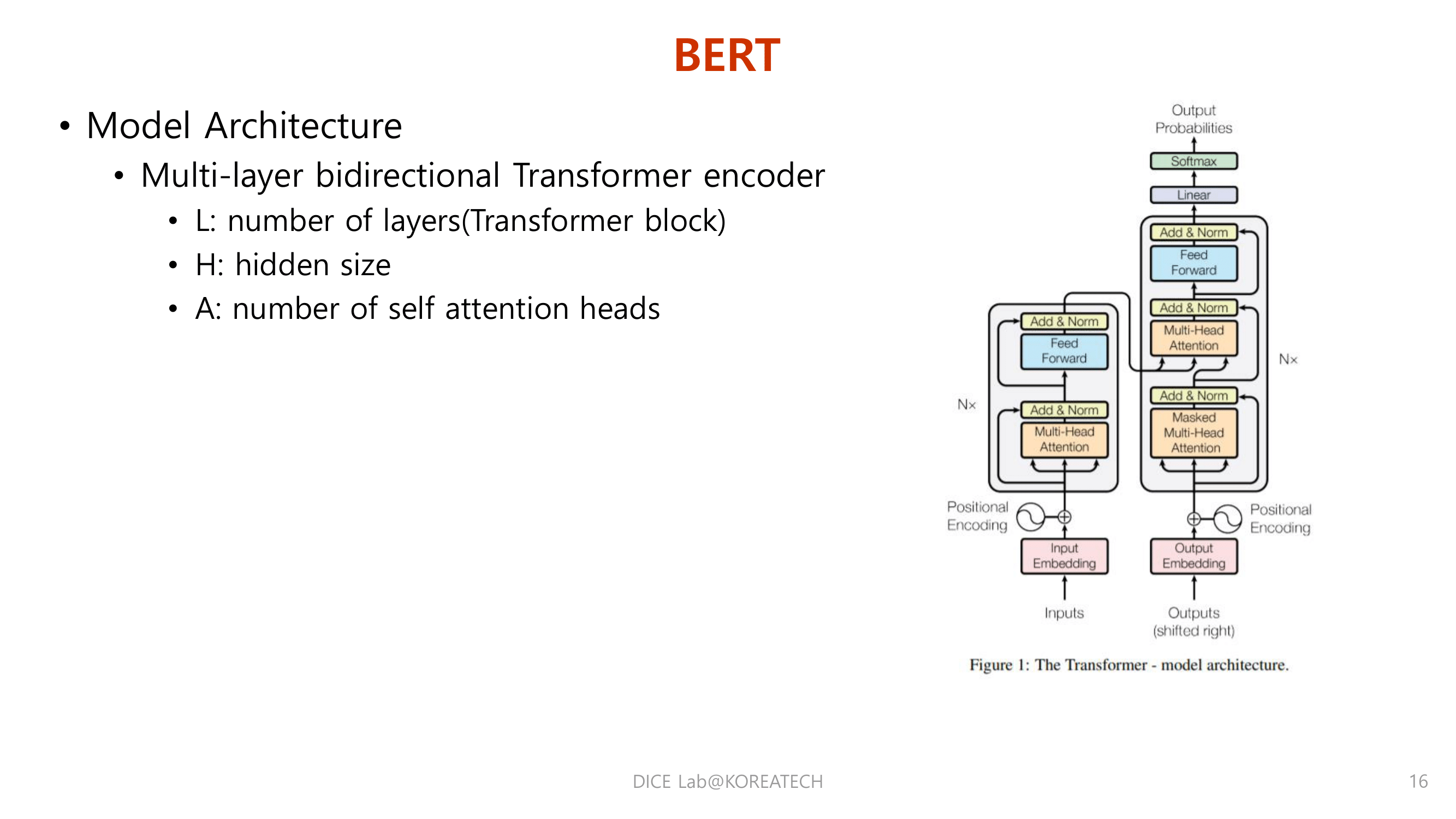

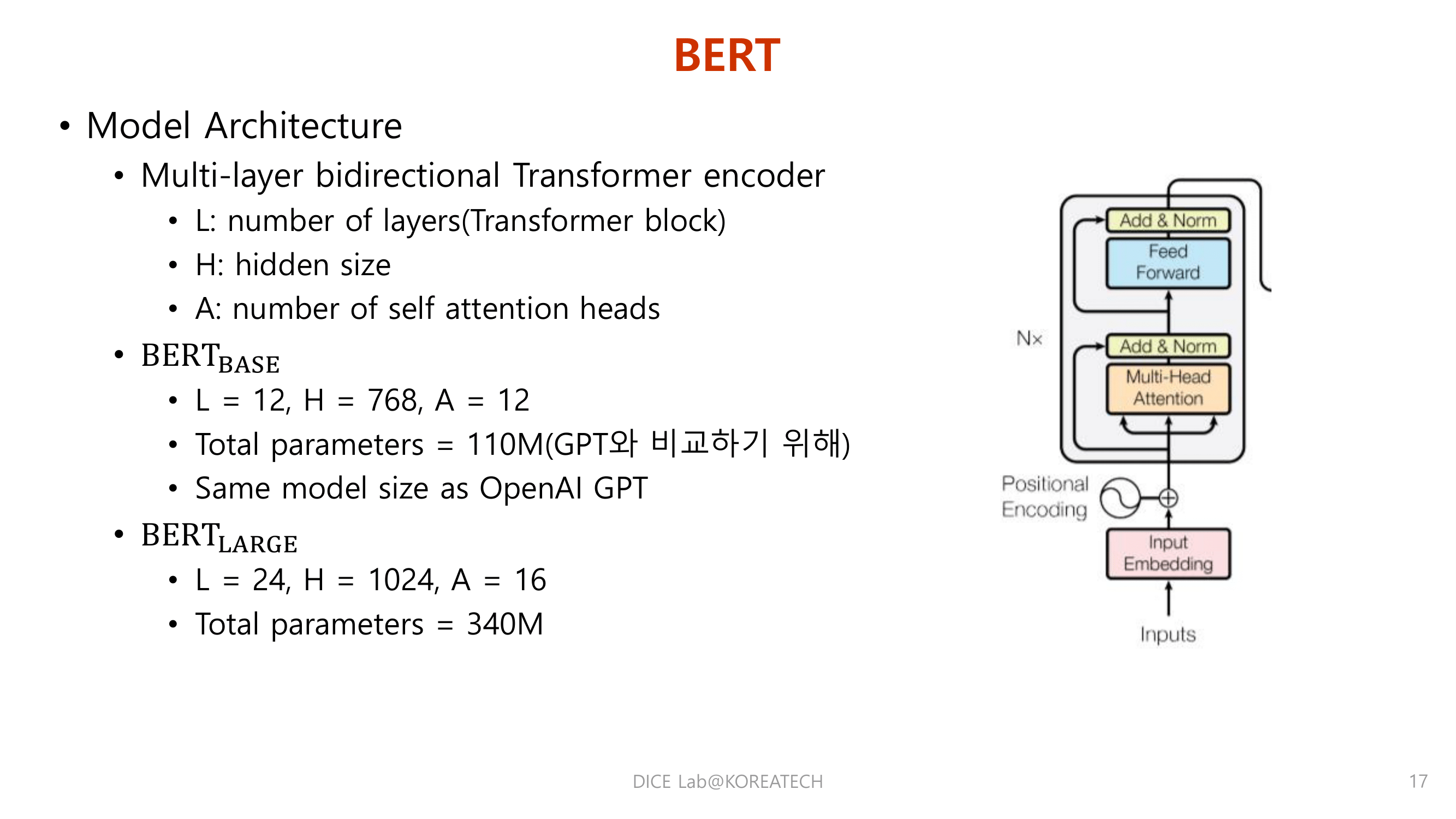

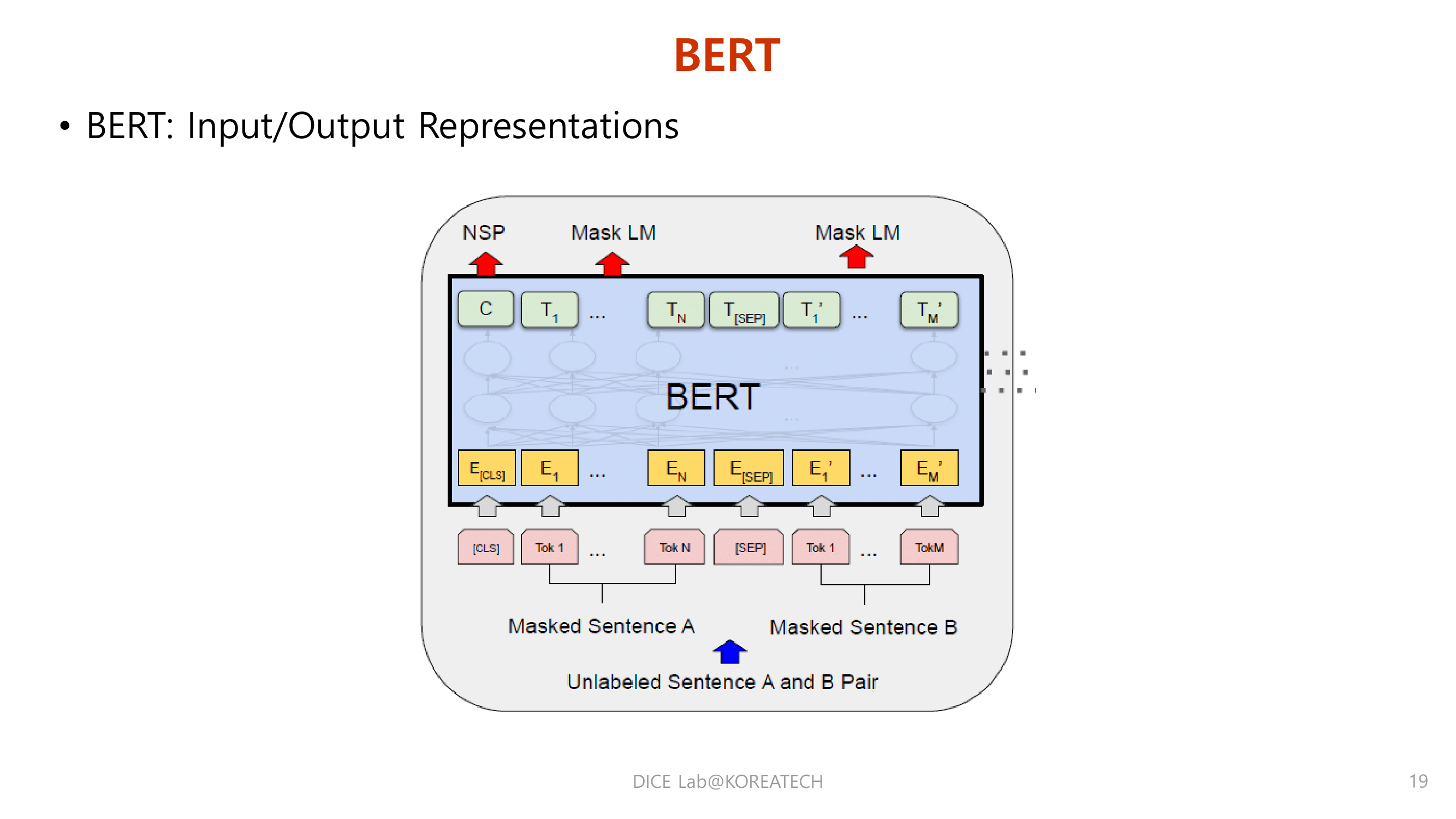

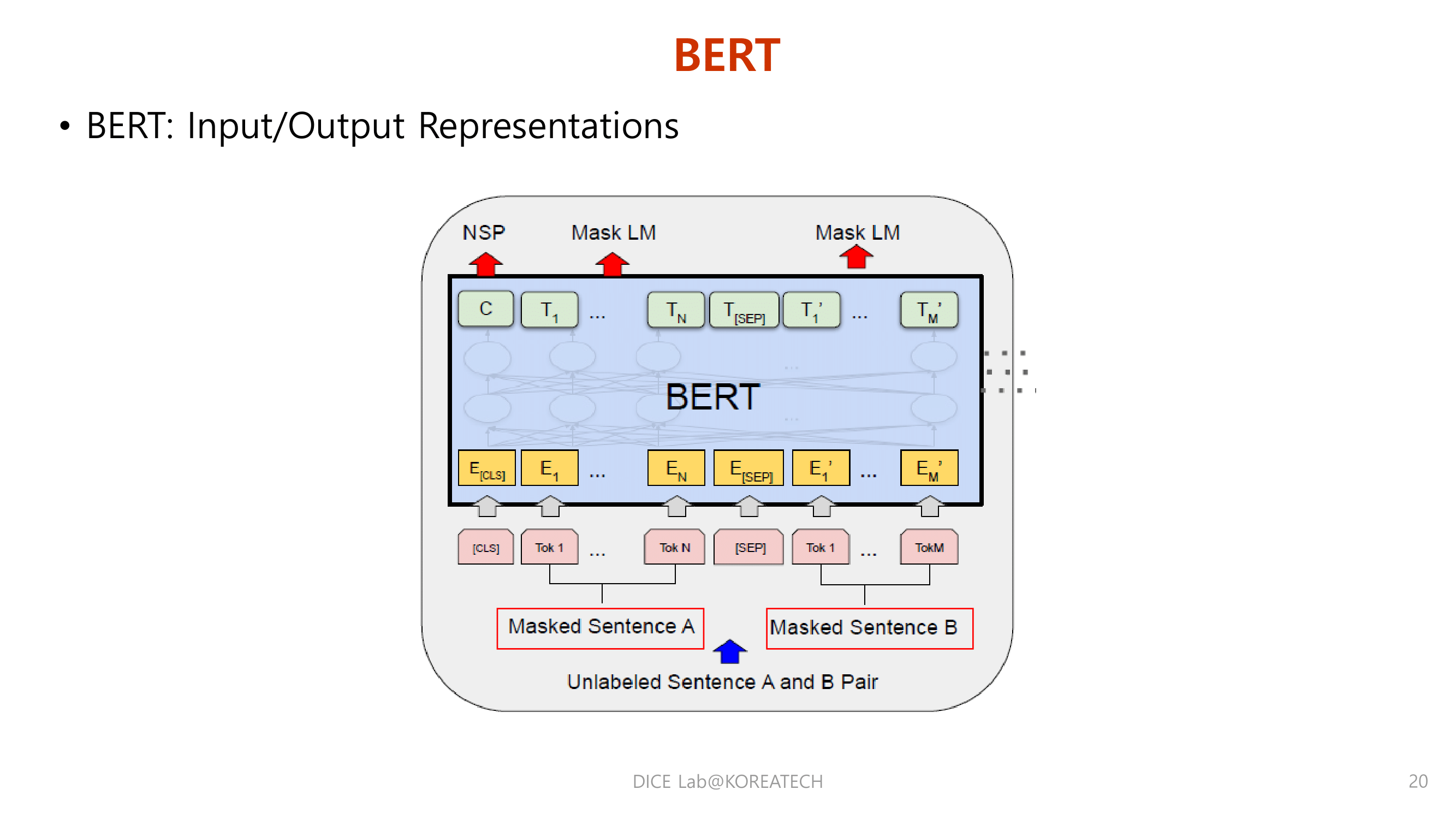

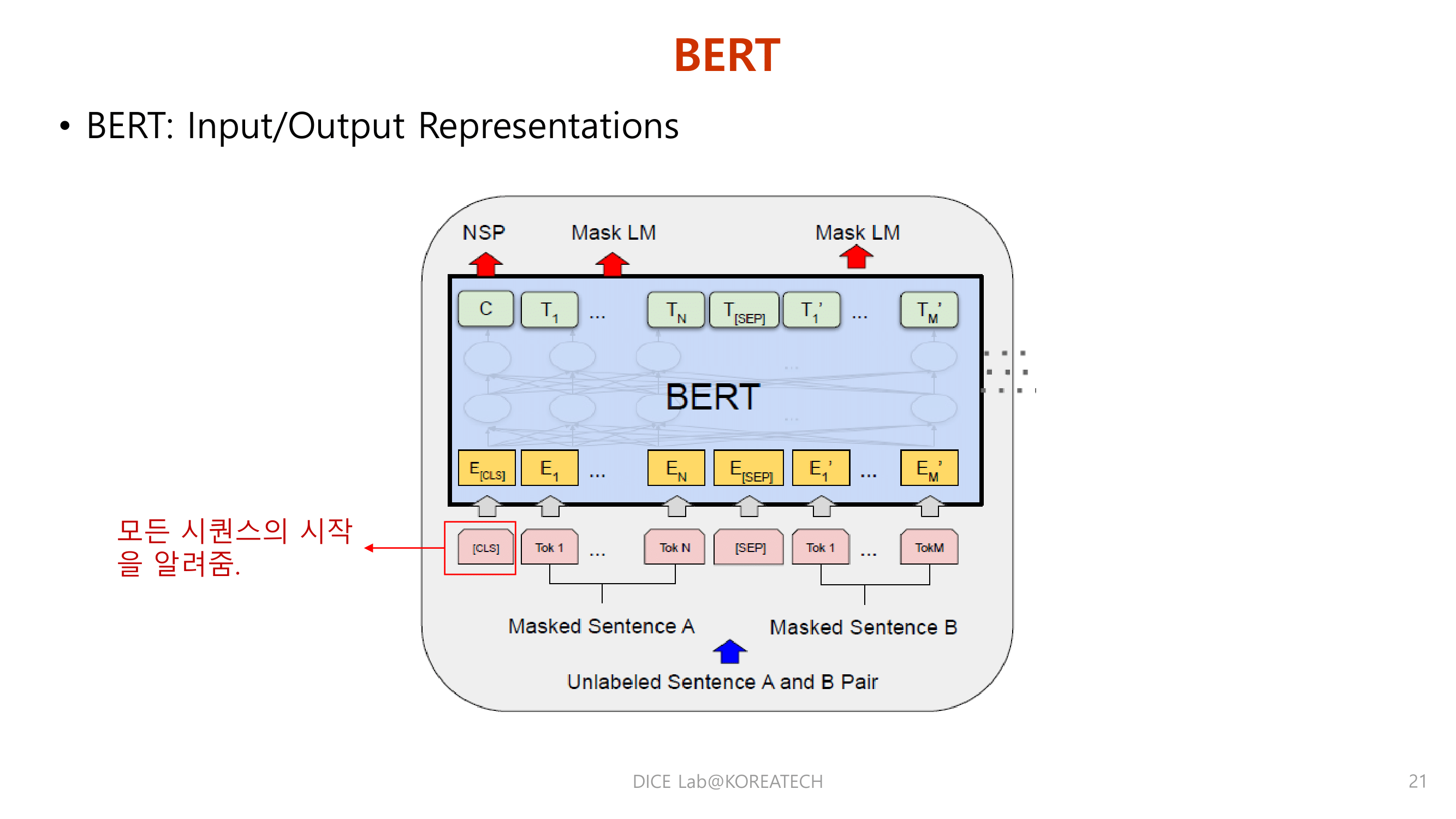

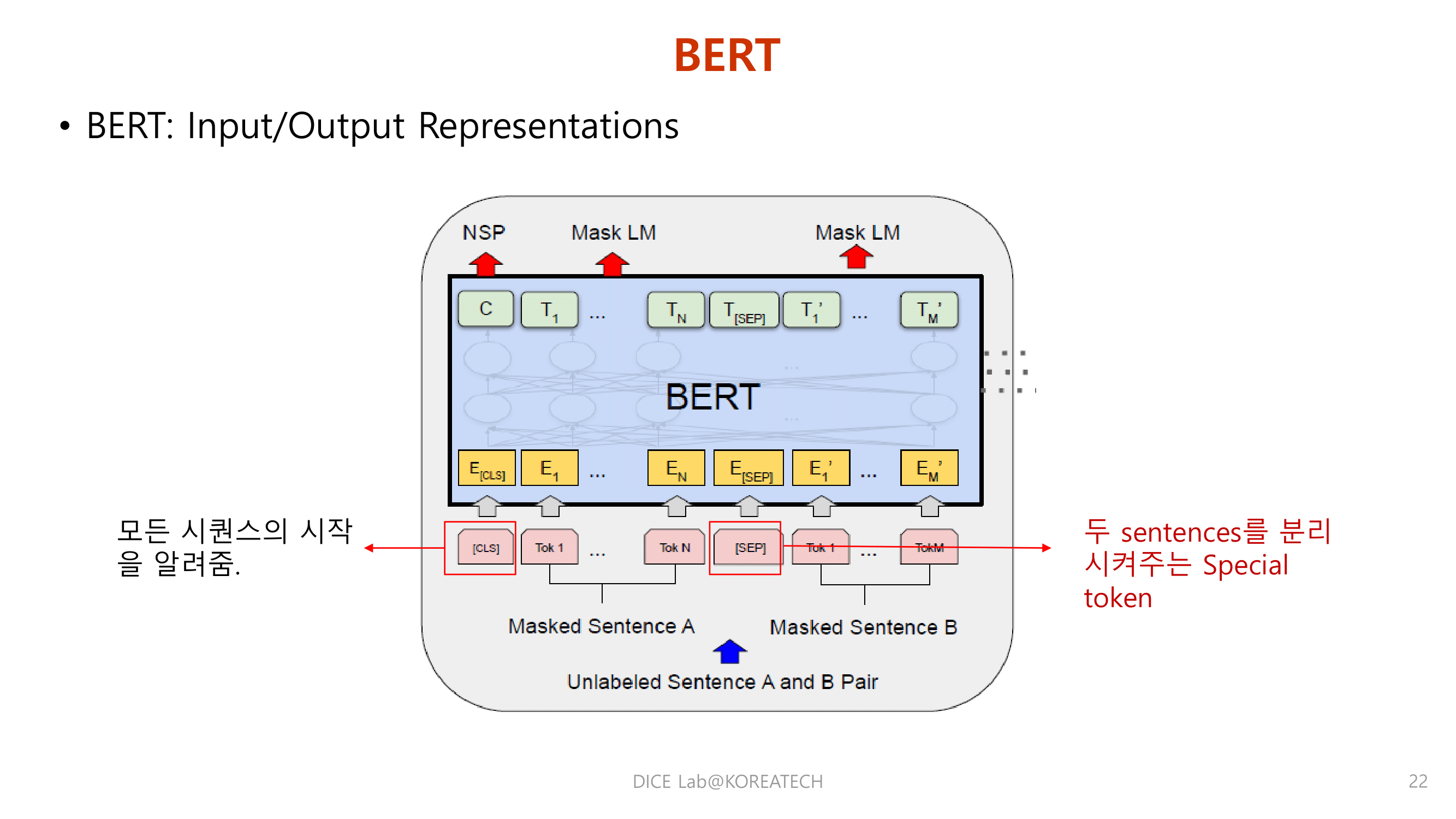

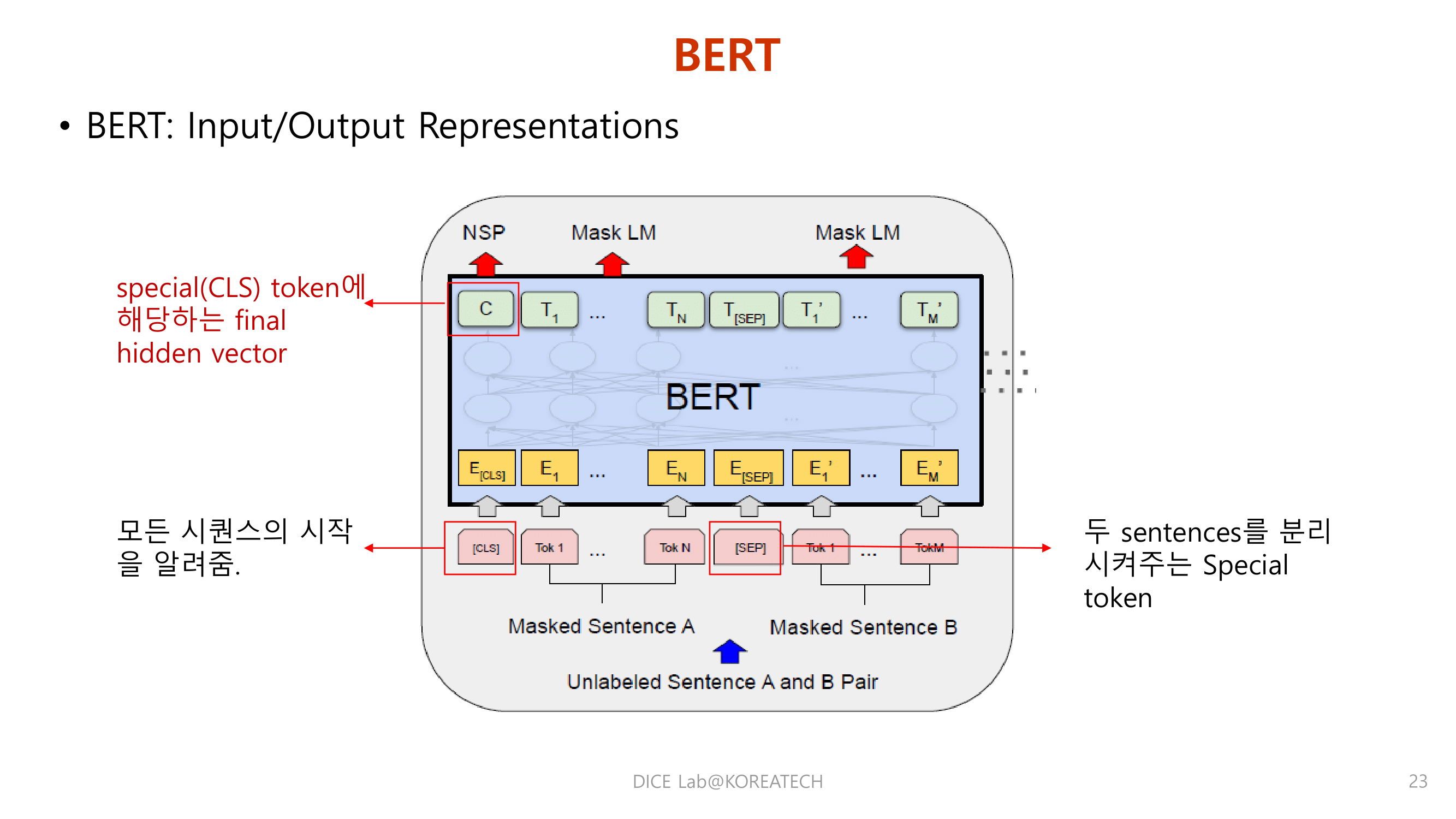

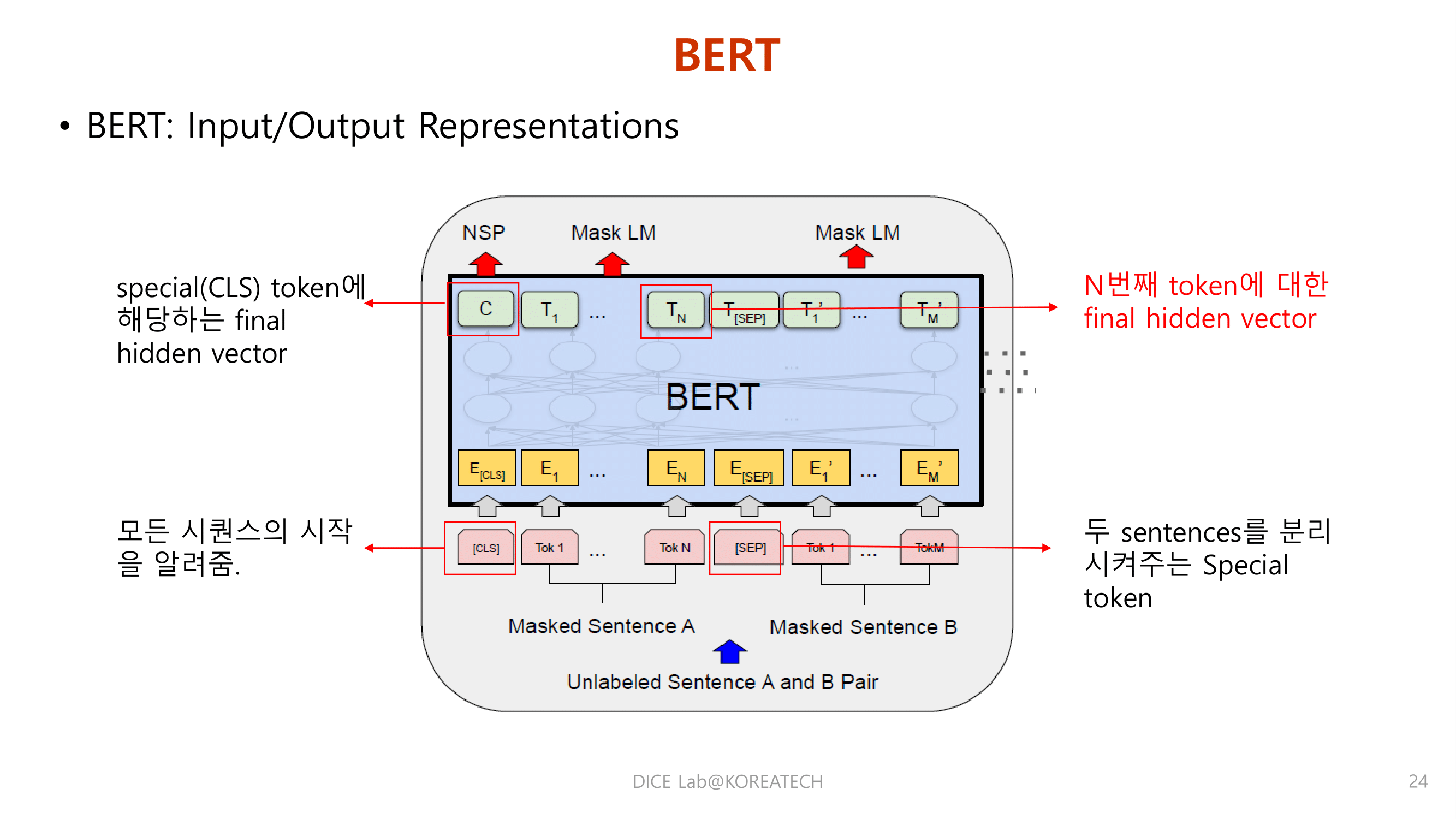

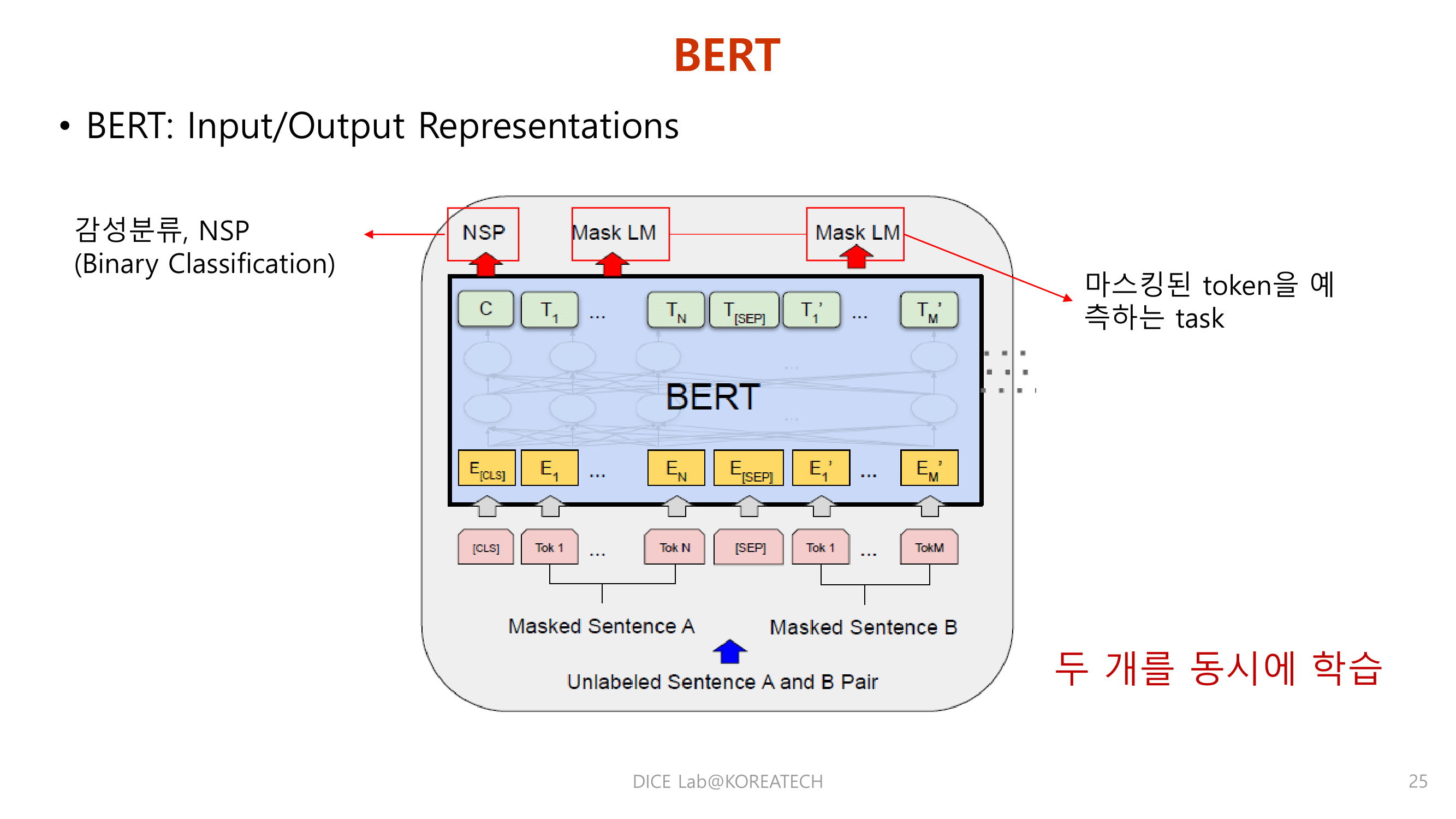

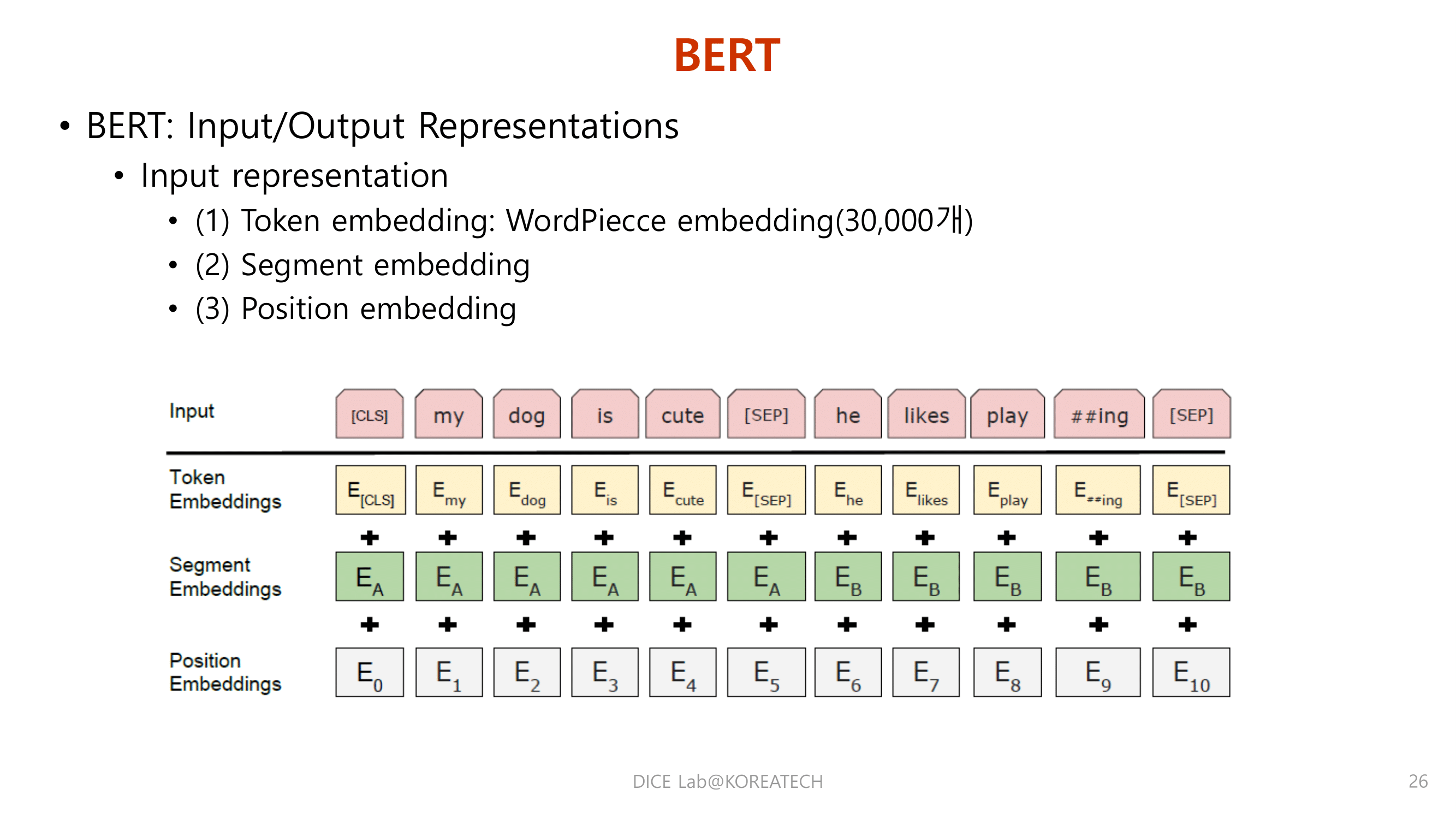

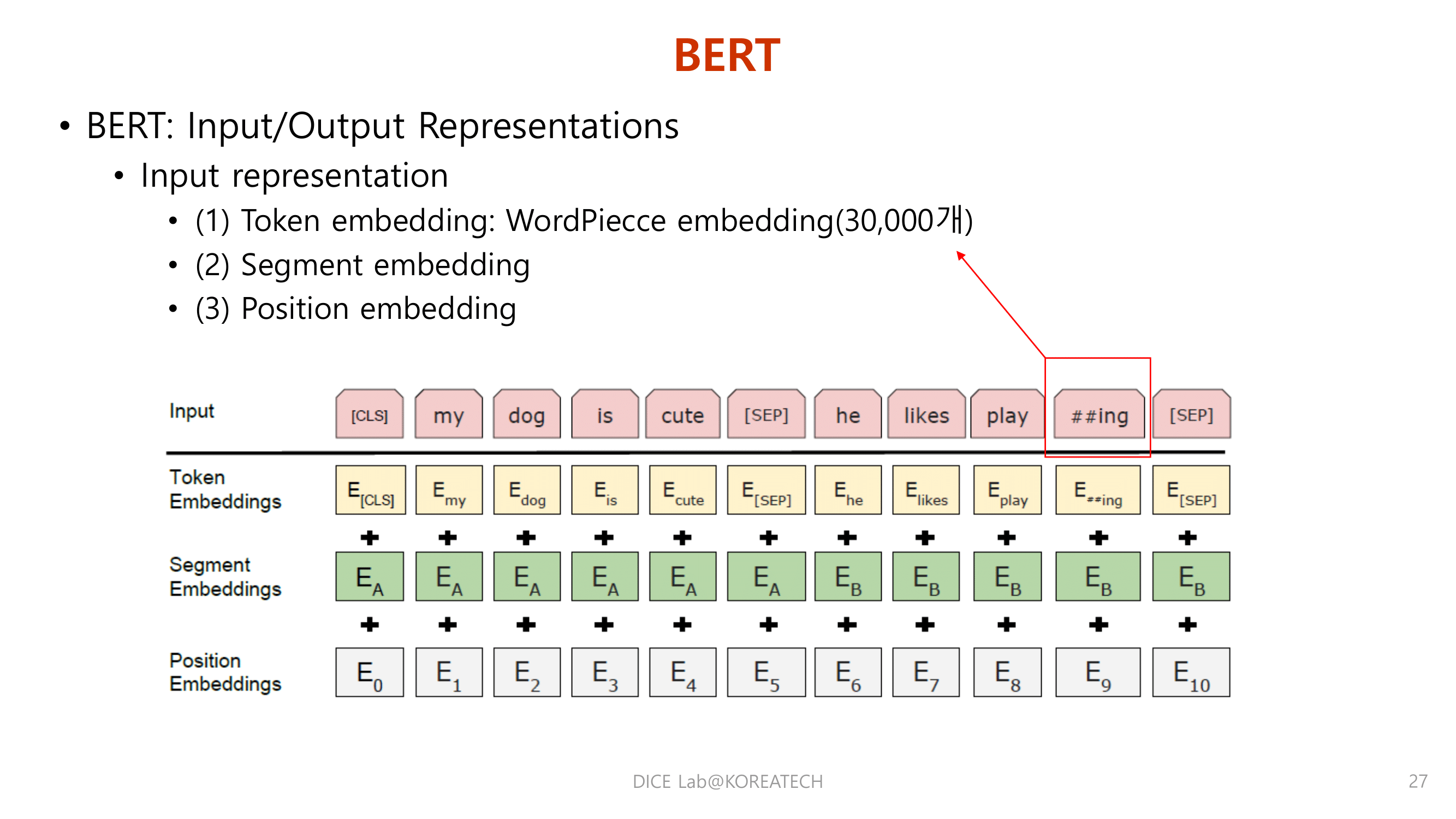

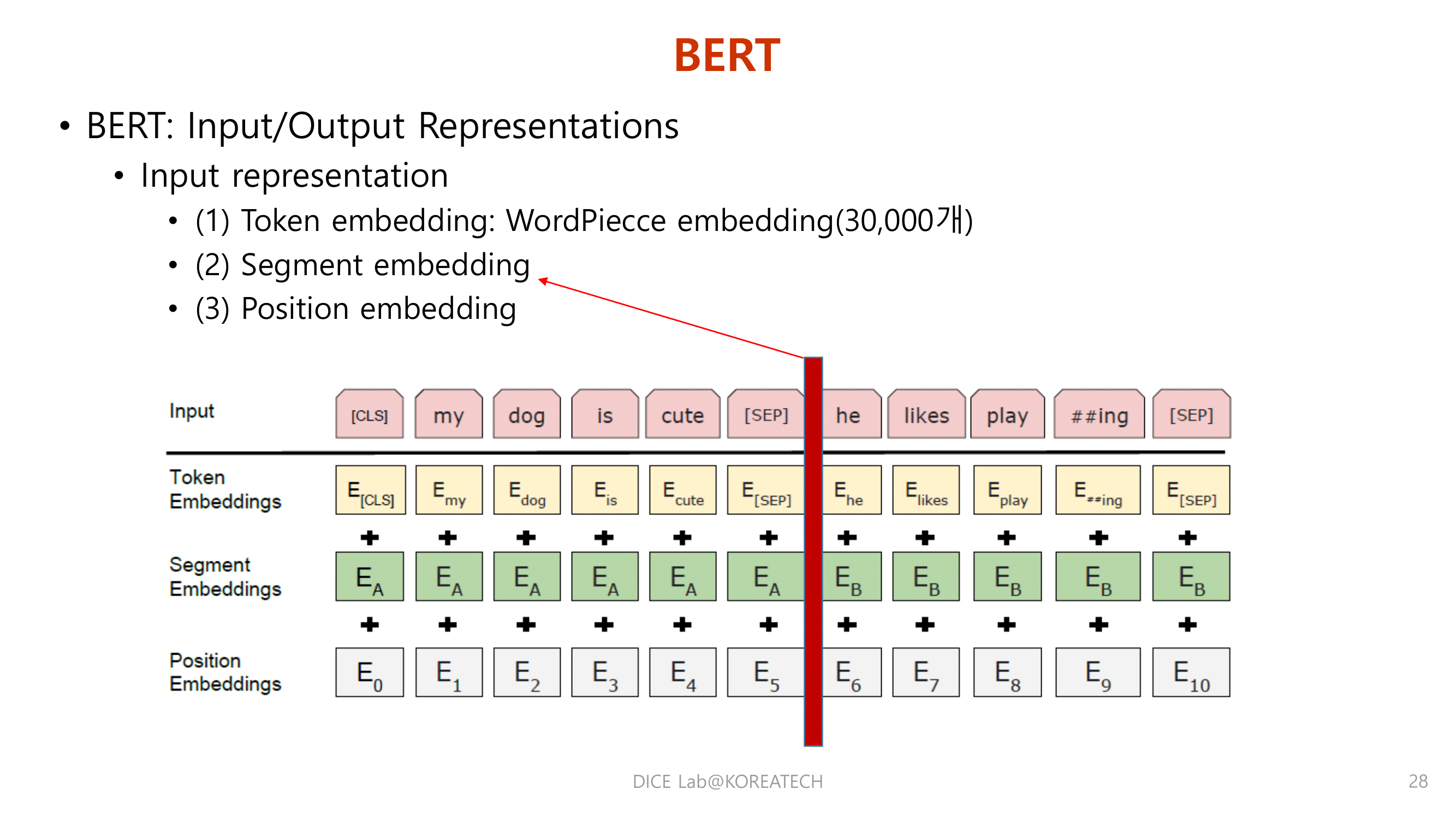

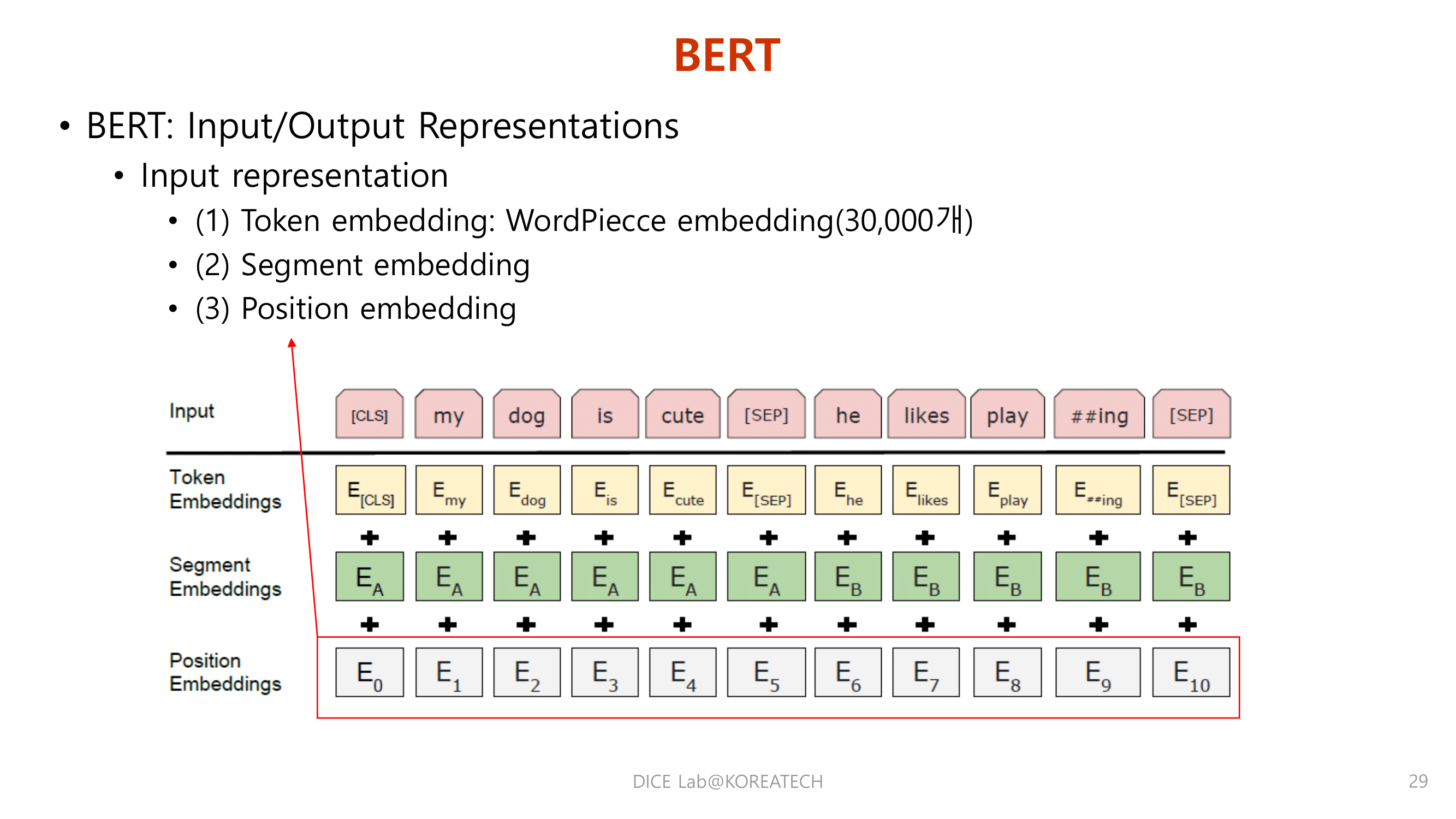

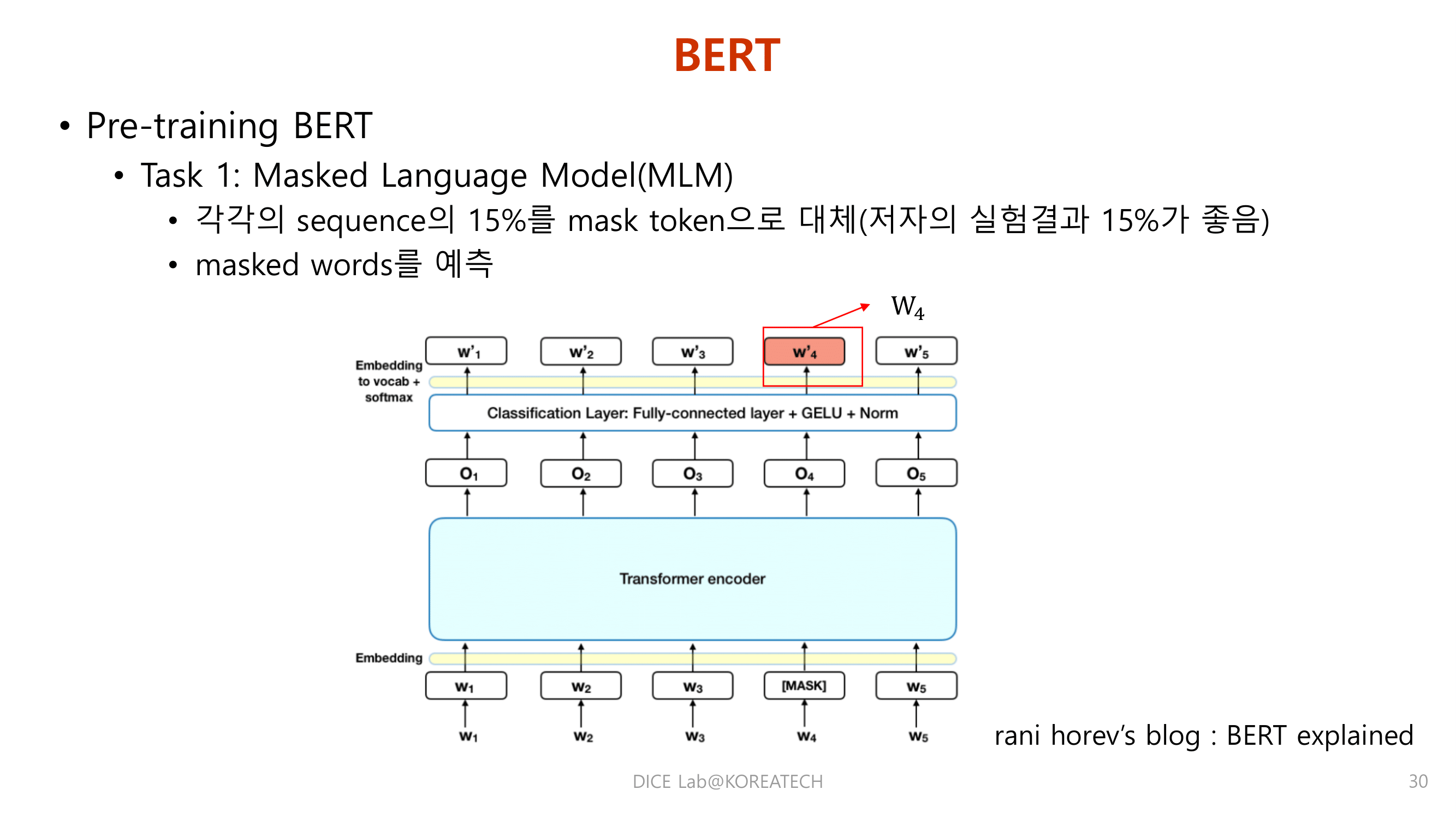

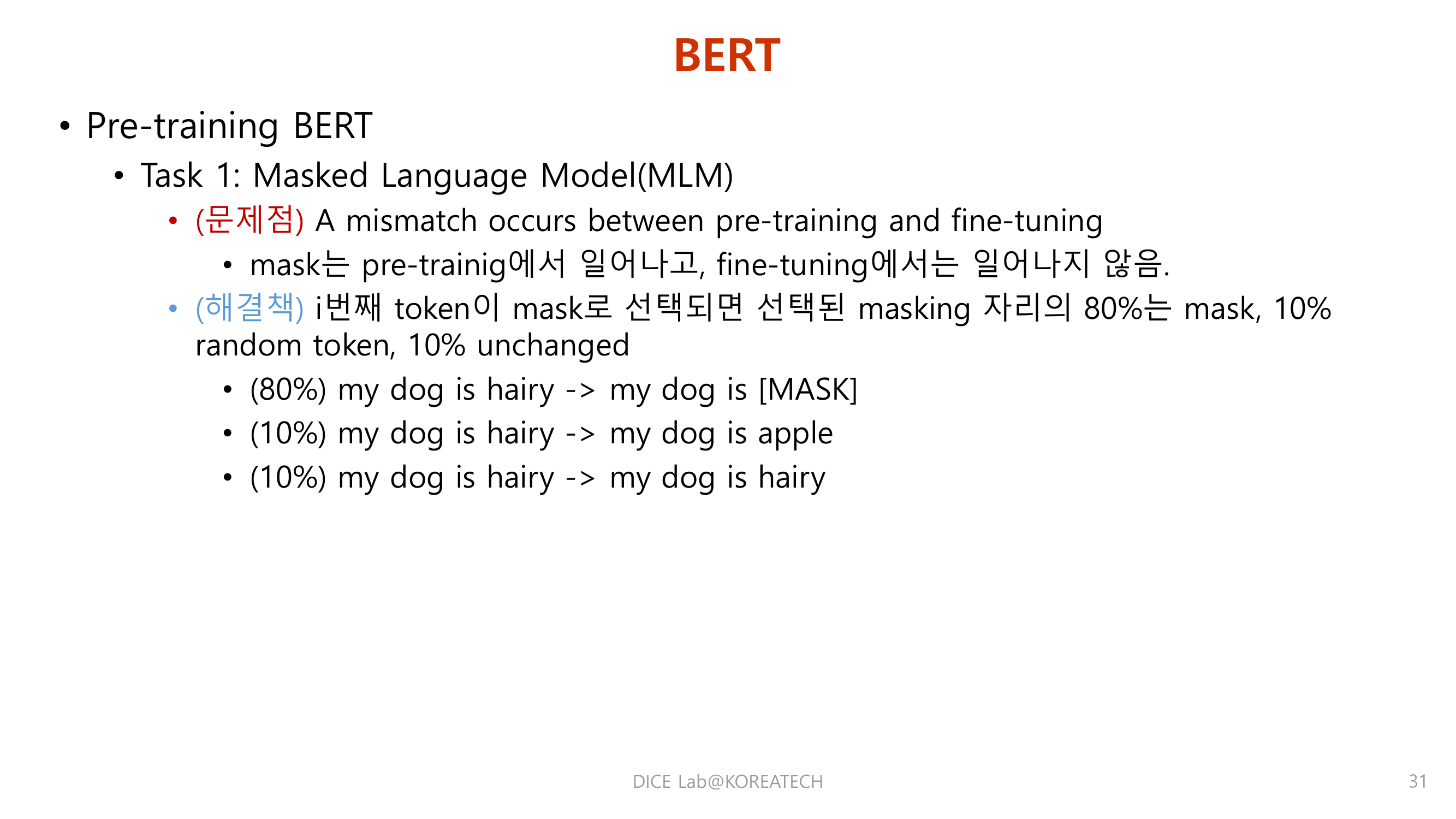

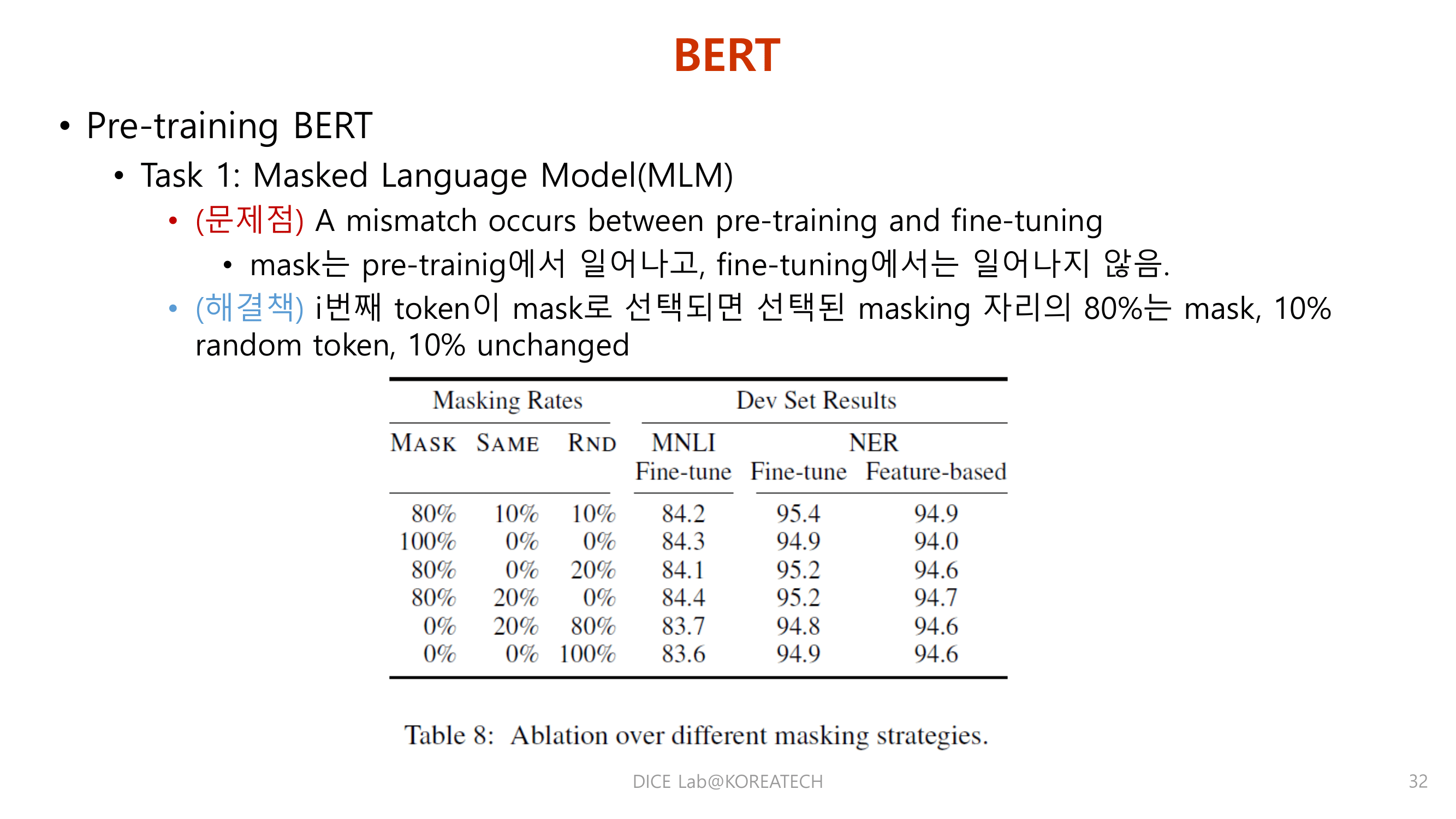

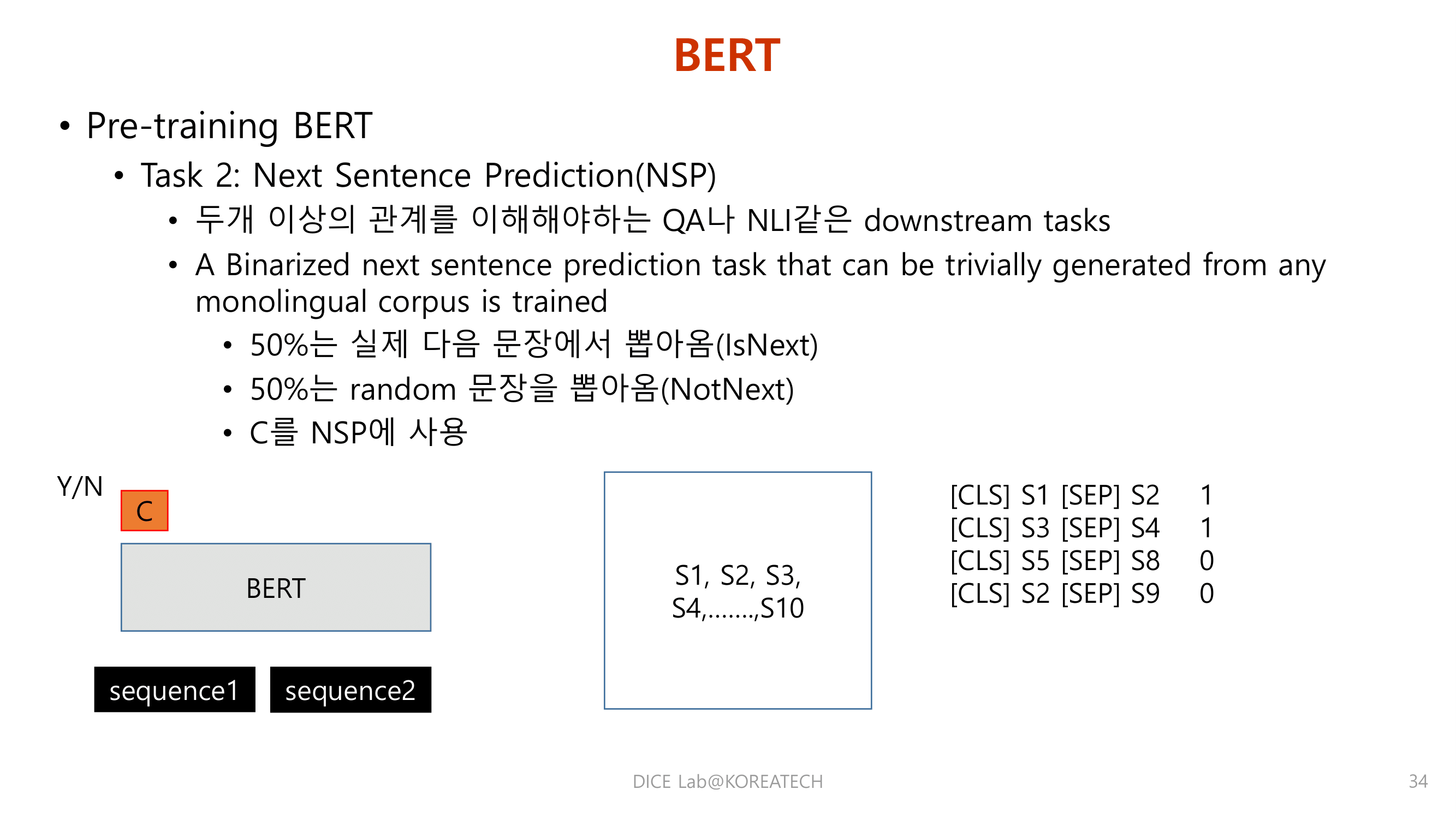

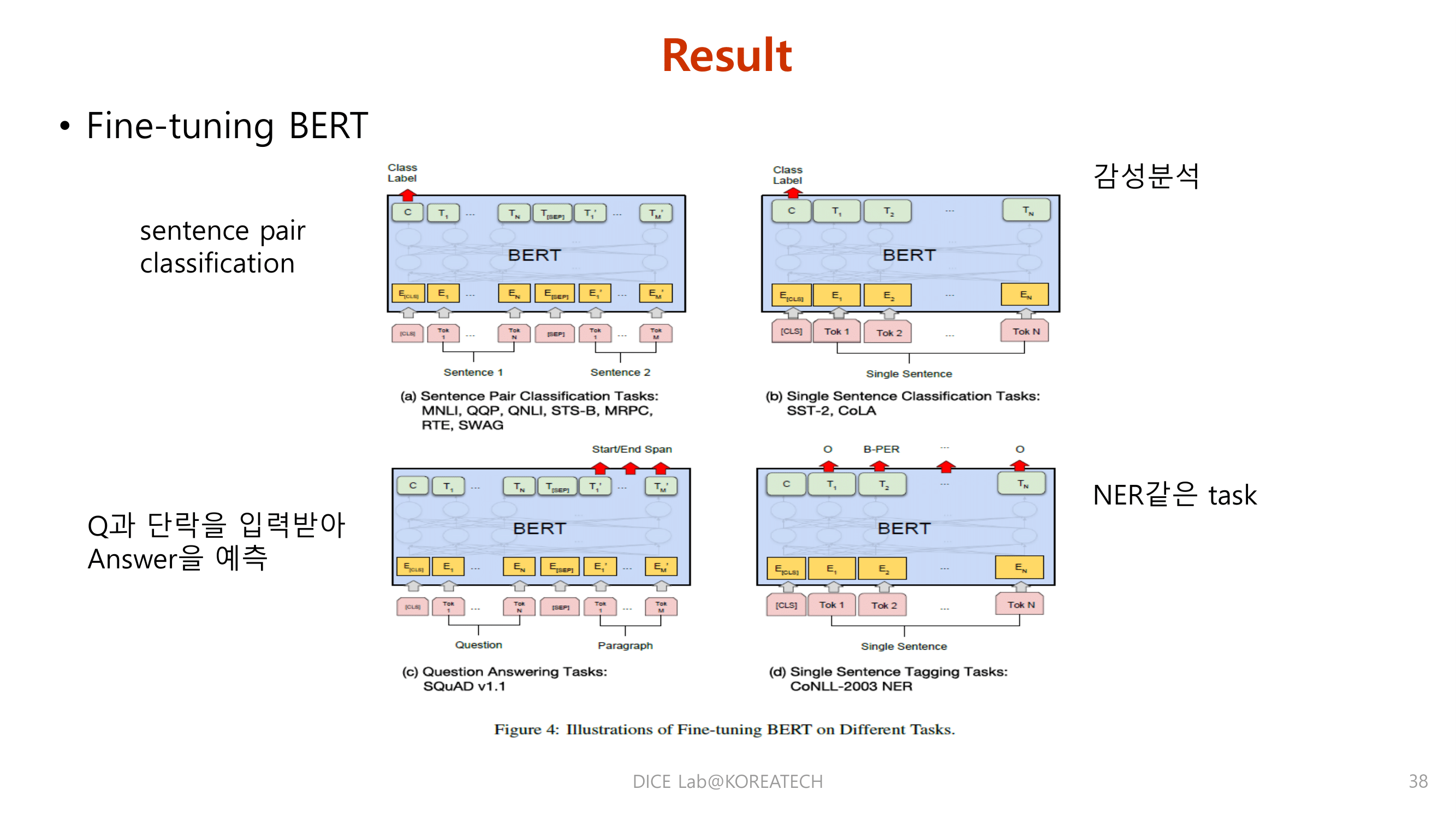

BERT

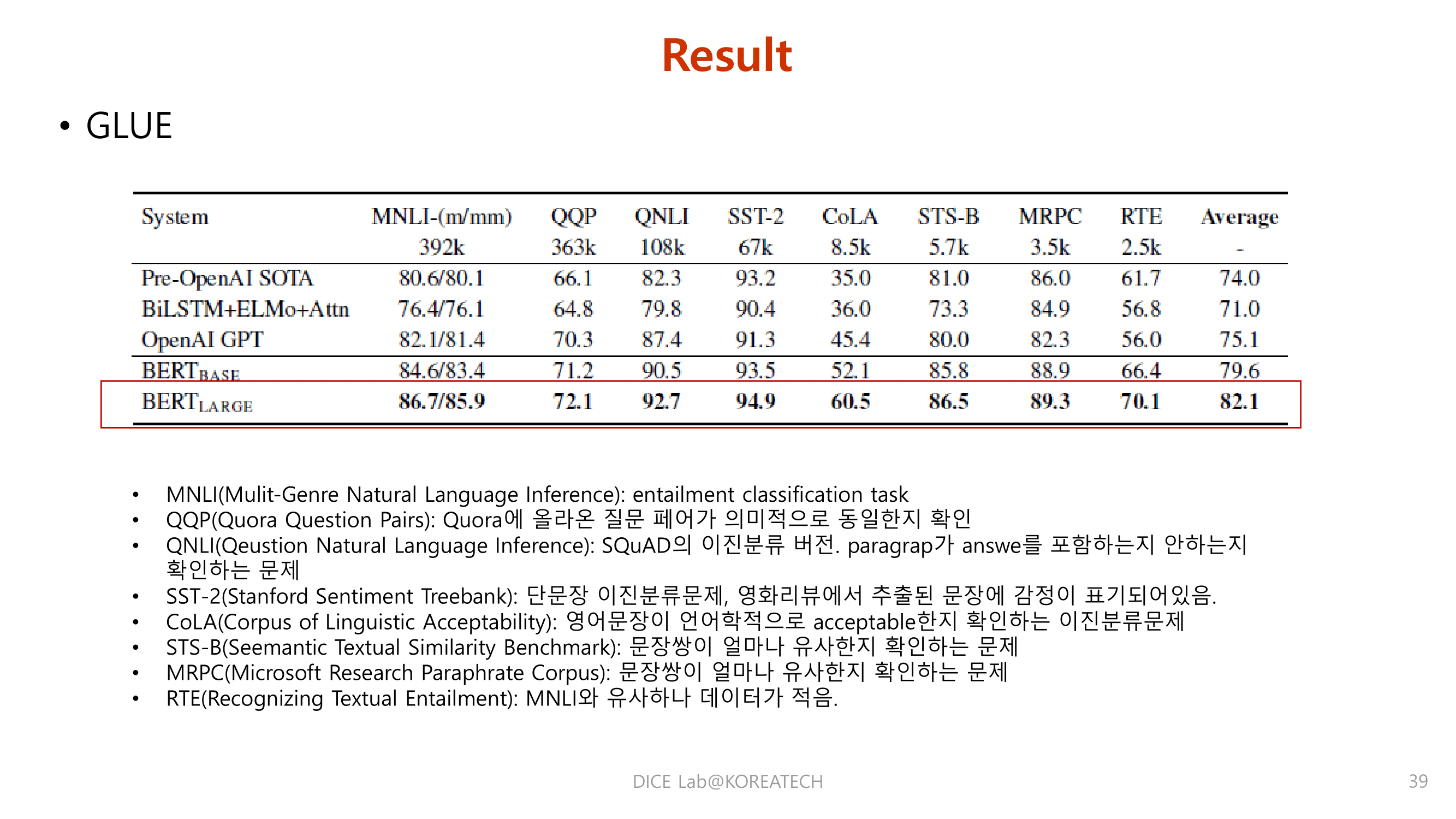

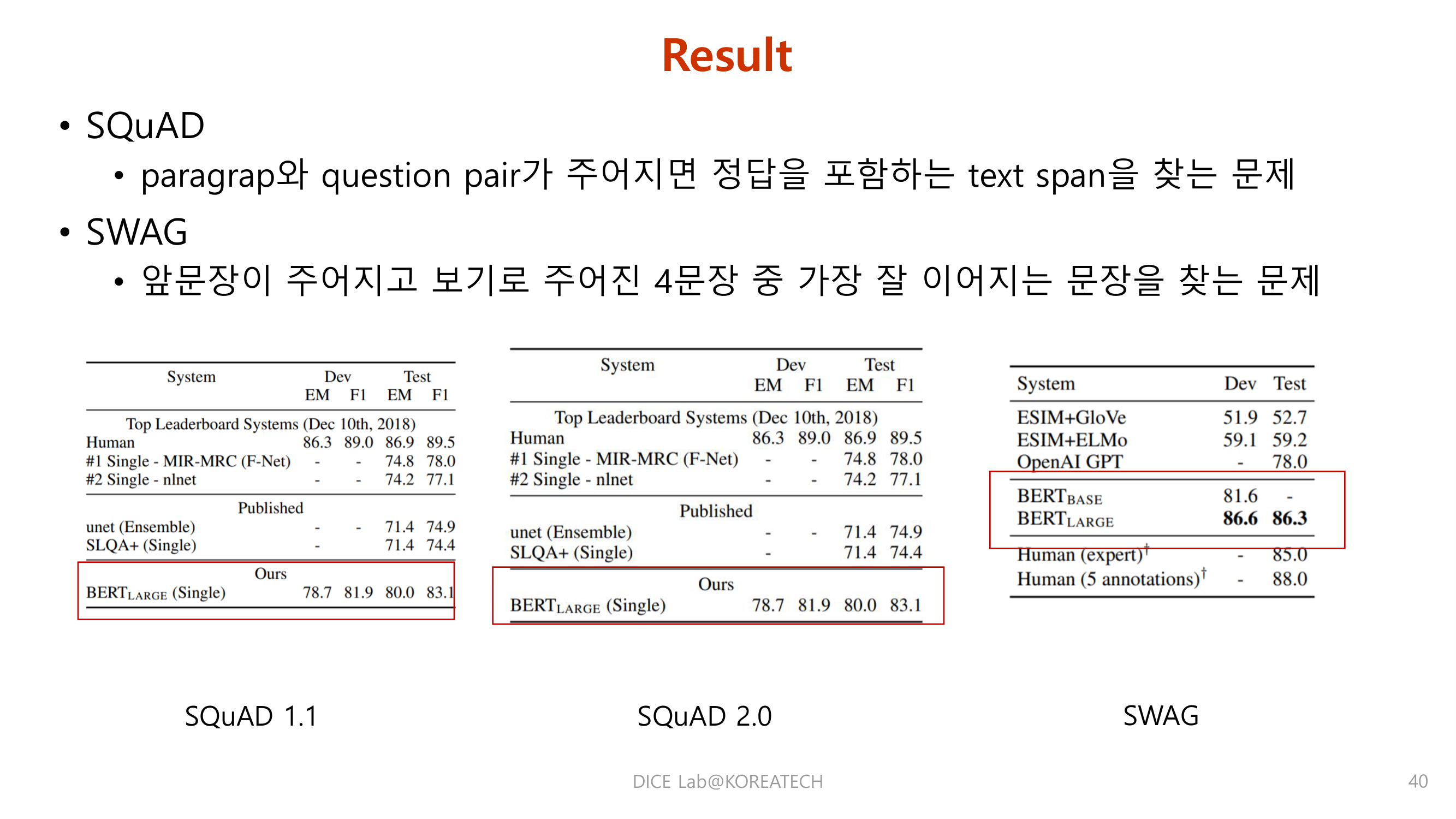

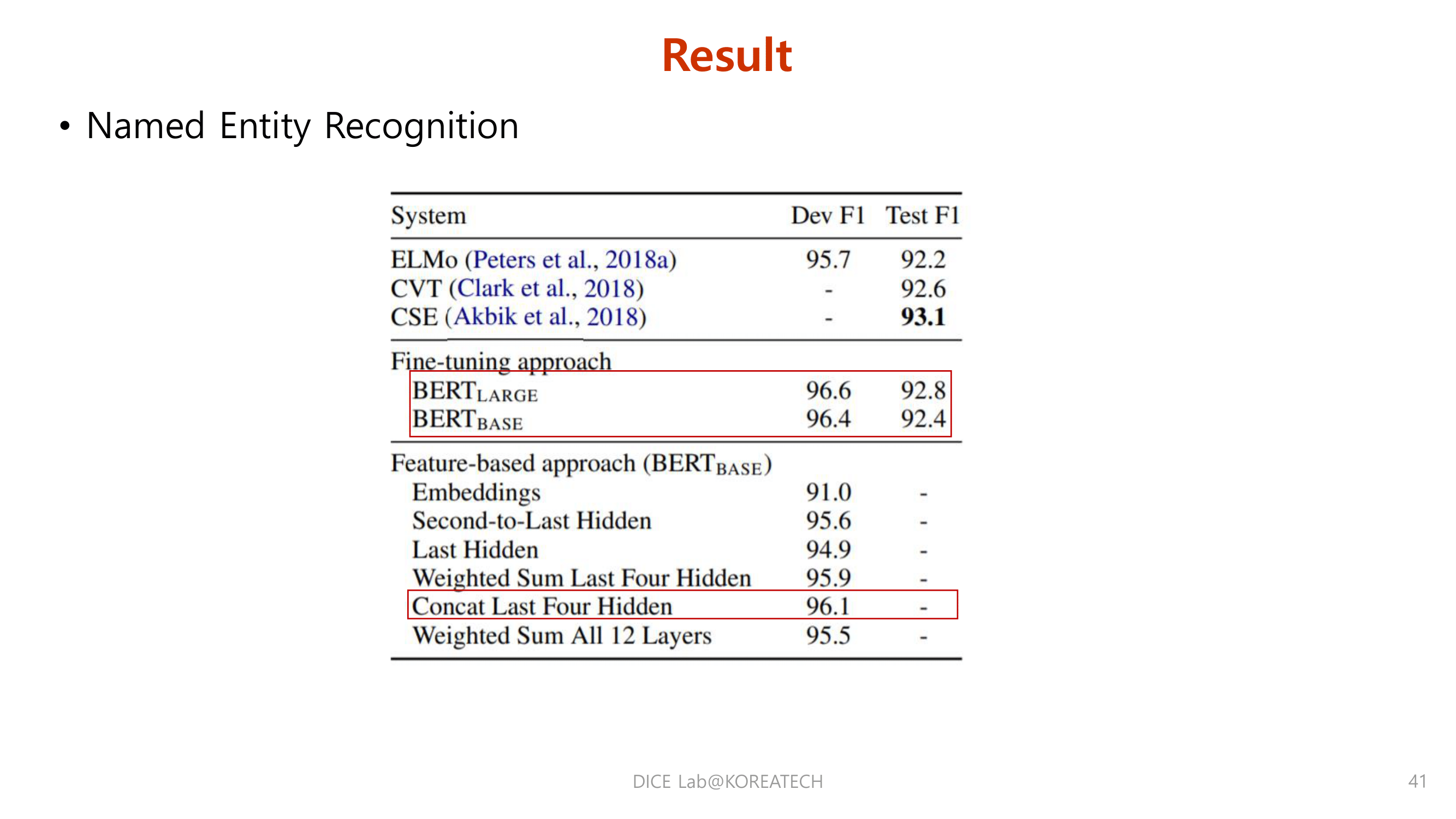

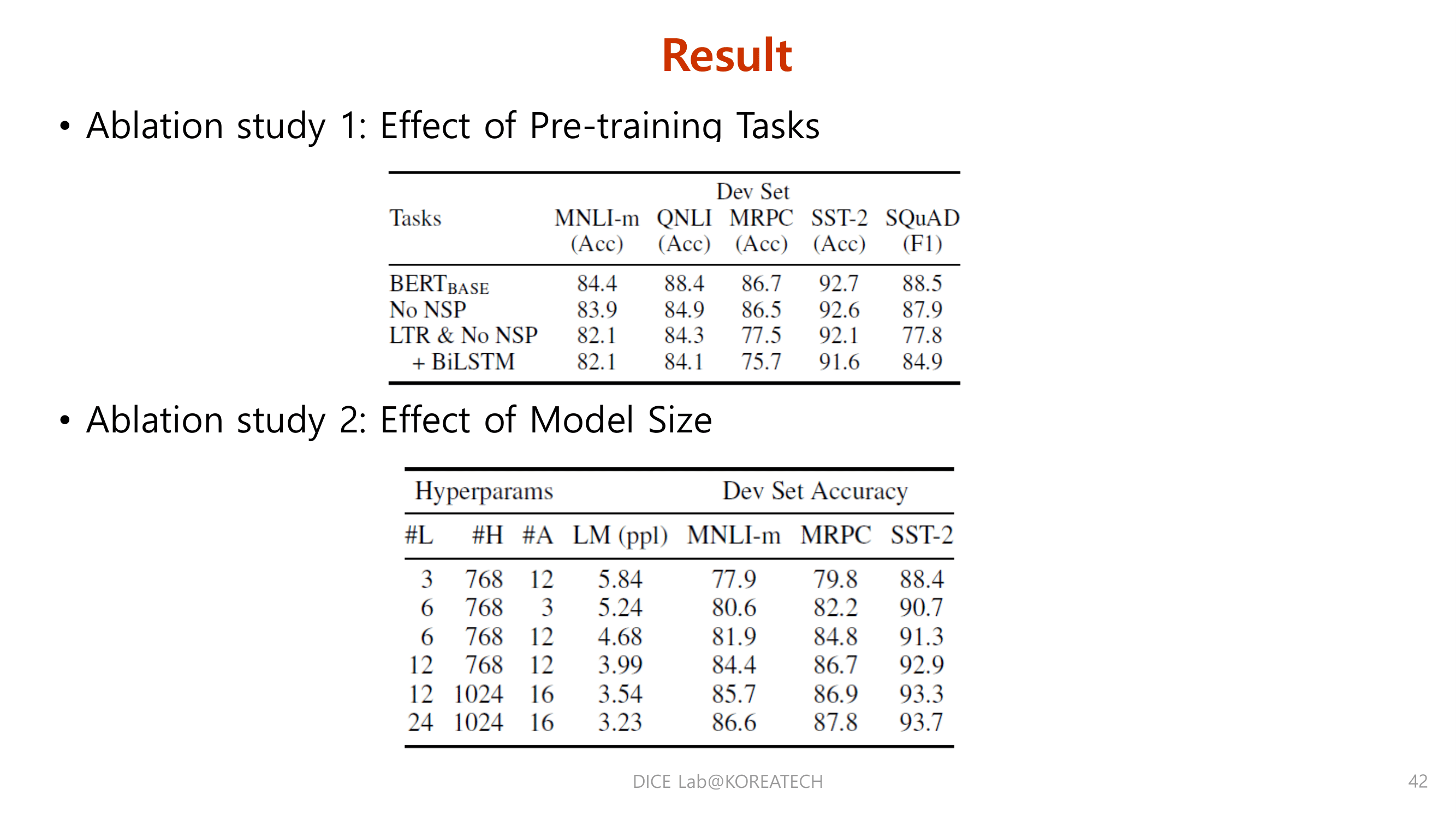

Experiments

Conclusions & Reviews

bidirectional 구조를 일반화시켜 Pre training 된 모델이 광범위한 NLP 작업을 성공적으로 처리할 수 있도록 기여함.

Fine tuning 을 위해 단순하게 bert 의 마지막 단에 한 개의 레이어를 추가해서 downstream task 를 수행한다는 점이 놀라웠다.

모델을 복잡하게 만들어서 성능을 올릴 수도 있지만 반대로 단순하게 접근해서 강력한 성능을 낼 수 있었다는 점이 매우 흥미로웠다.

Reference

This post is licensed under CC BY 4.0 by the author.